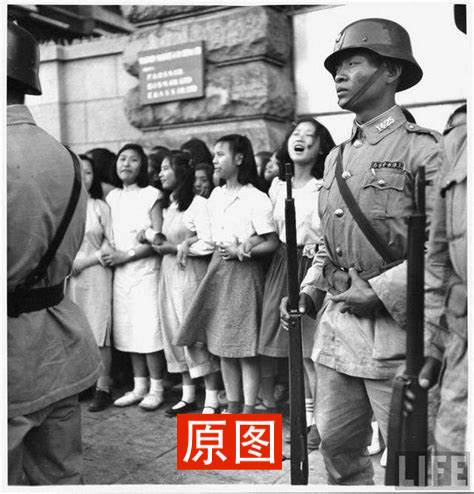

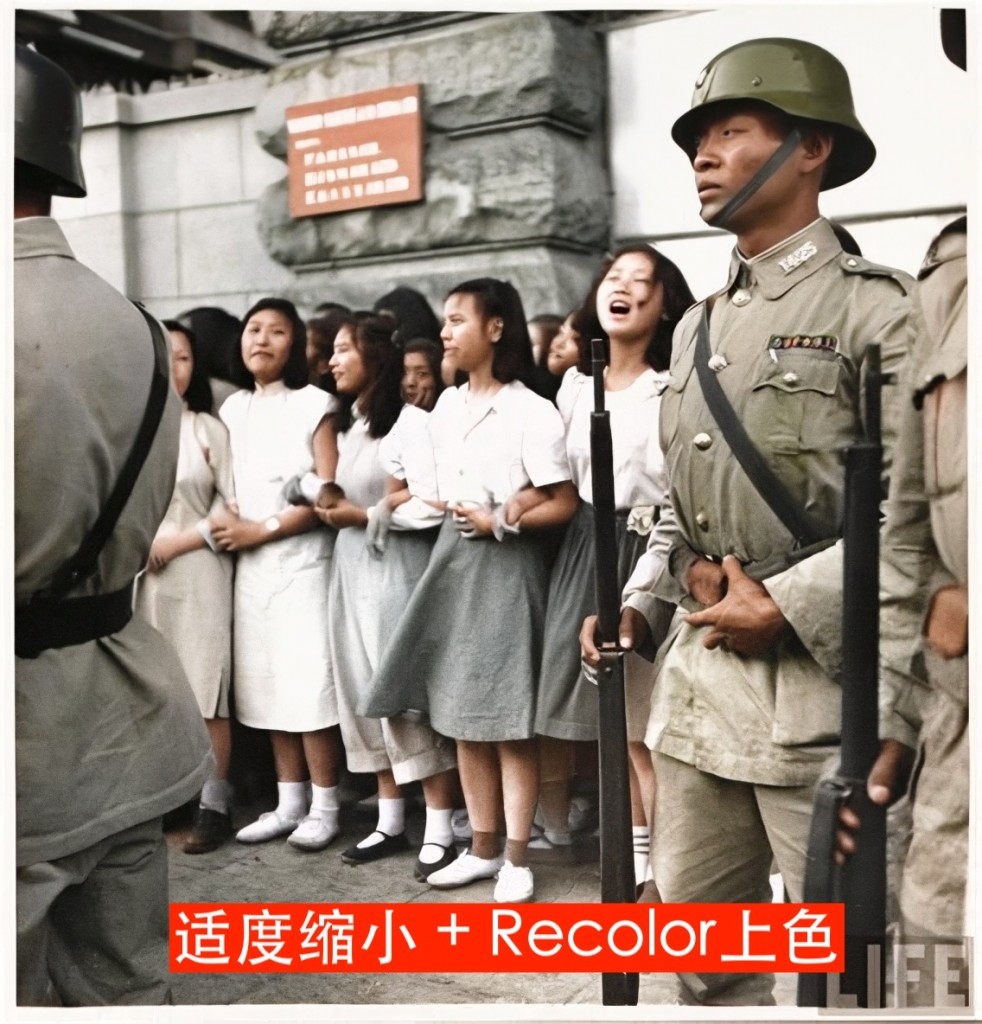

今天来说一个StableDiffusion的实用技术:老照片放大上色。StableDiffusion里有不少功能都能对图片做放大,但是对比下来,针对不同的照片类型,效果还是差异很大的,这里就介绍一种对小尺寸、但相对清晰的黑白照片的处理过程。分两步,先放大、再上色。

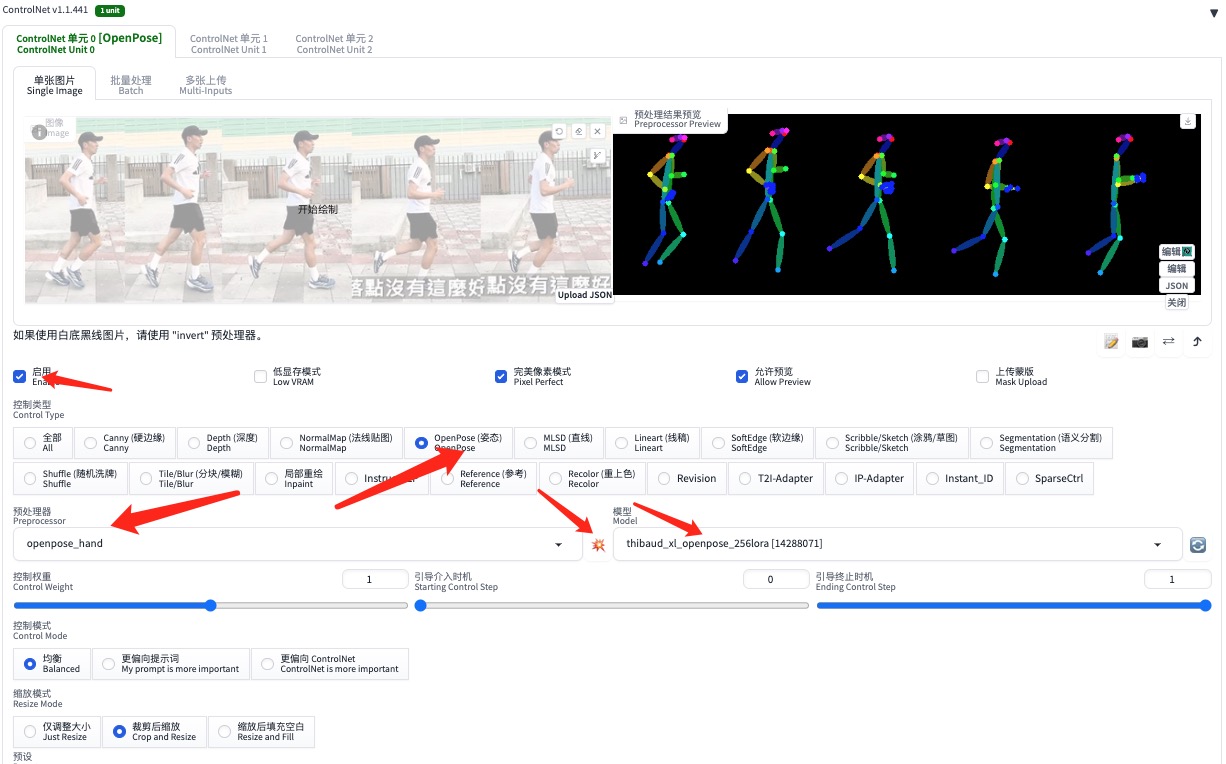

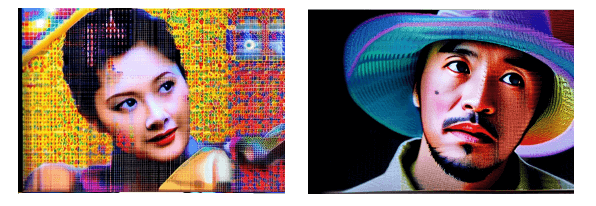

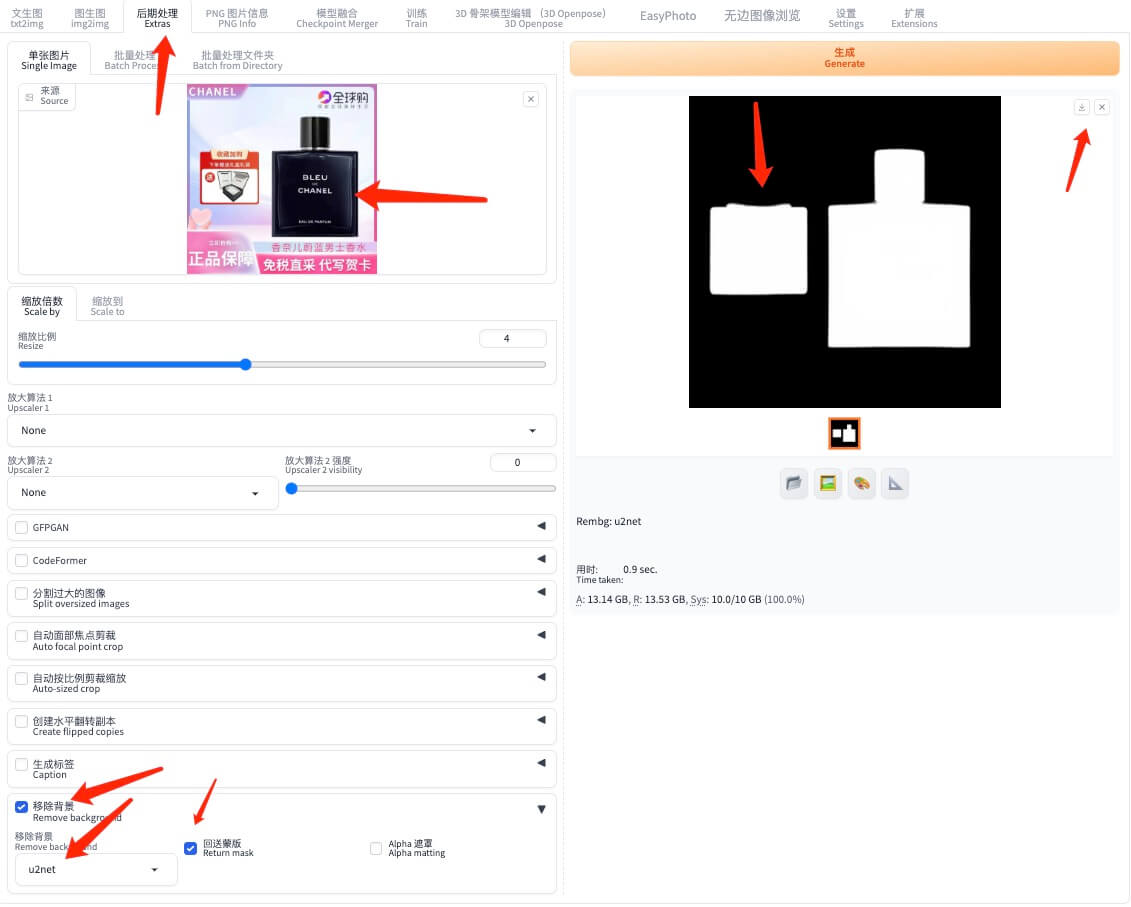

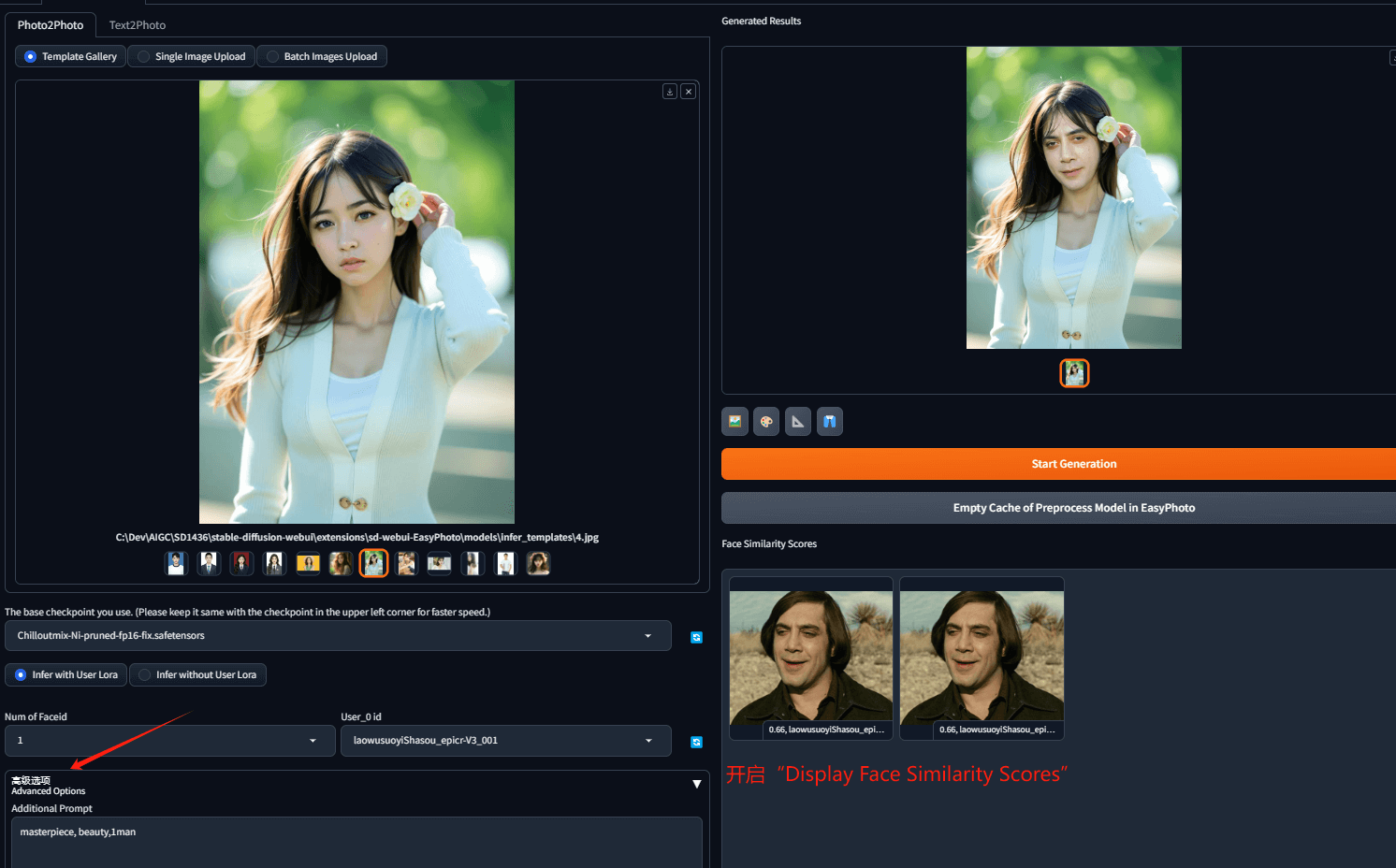

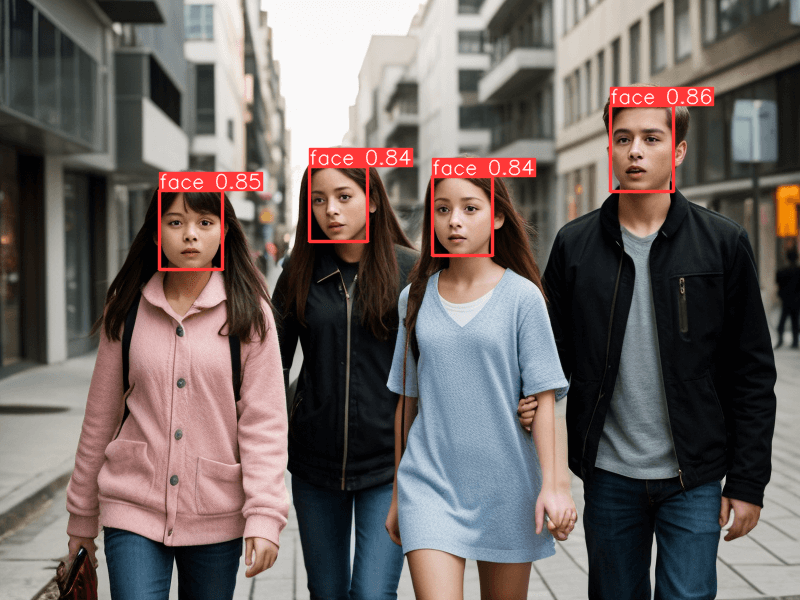

第一步,进入“后期处理”选项卡(有些版本也翻译成“附加功能”),按下图所示做设置、对图片做放大

如果放大效果不理想,可以调整放大算法多尝试几次。关于各种放大算法的差异,可以参阅这篇知乎文章:https://zhuanlan.zhihu.com/p/672717691

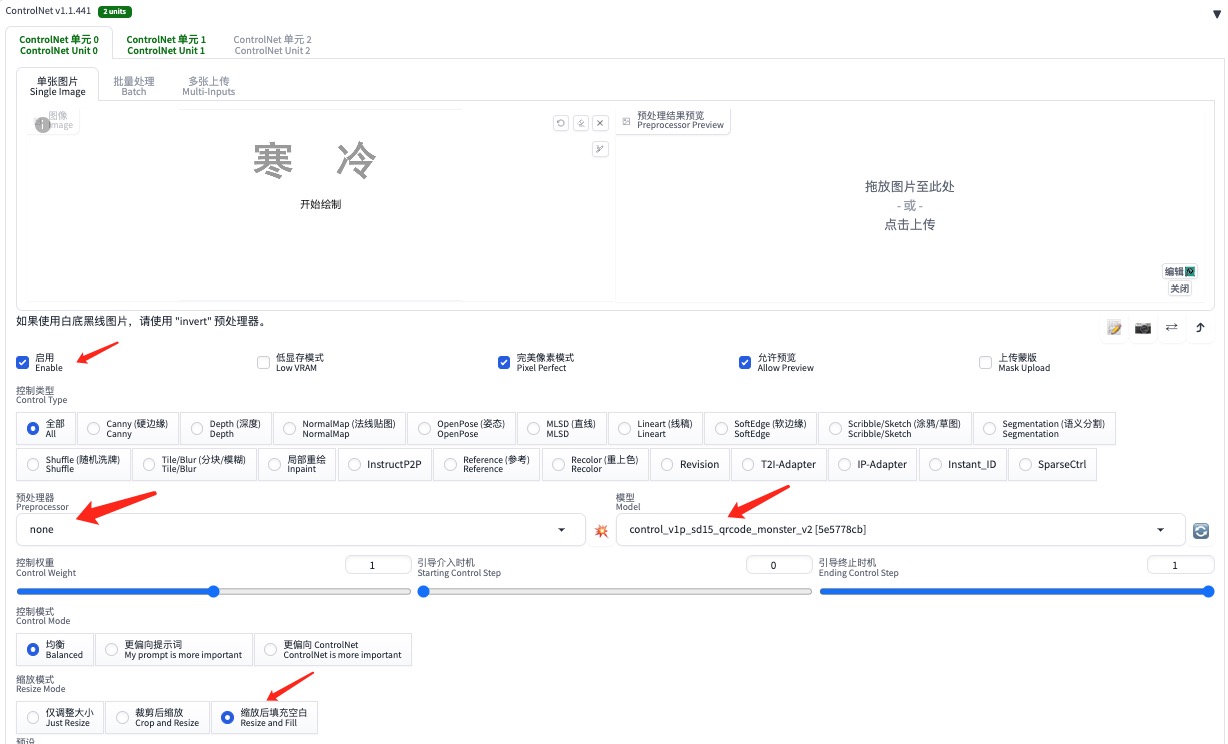

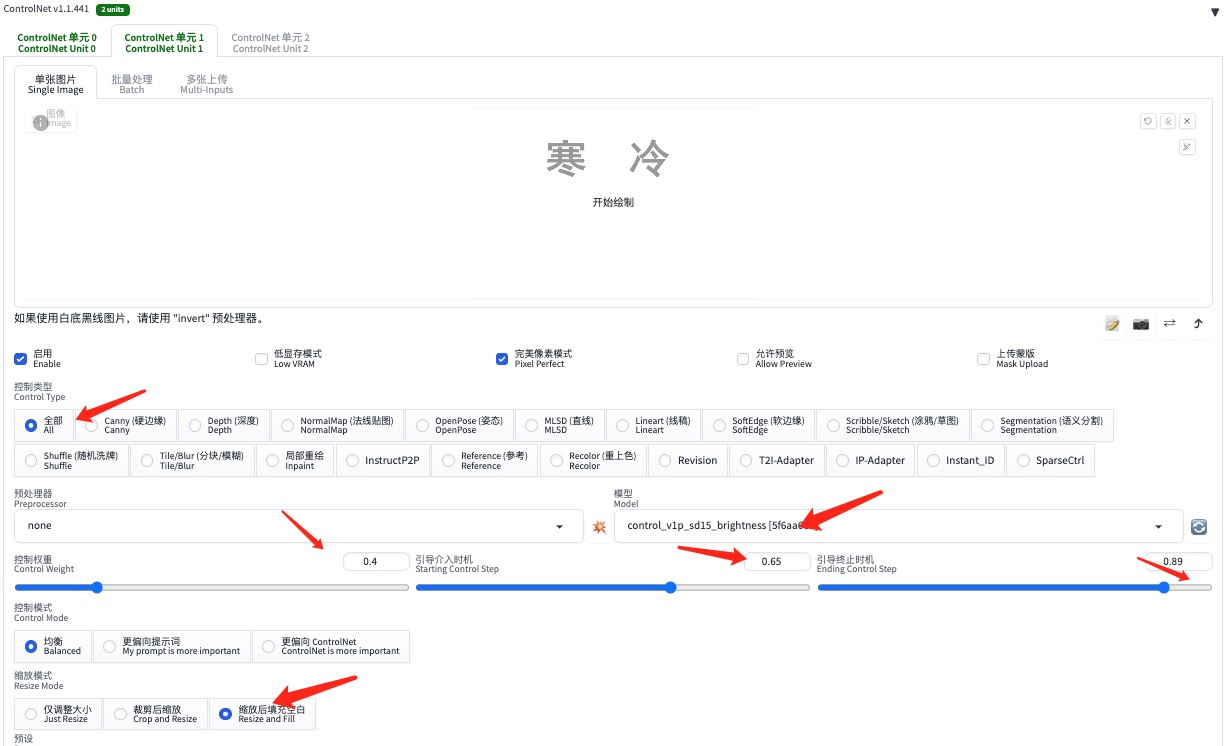

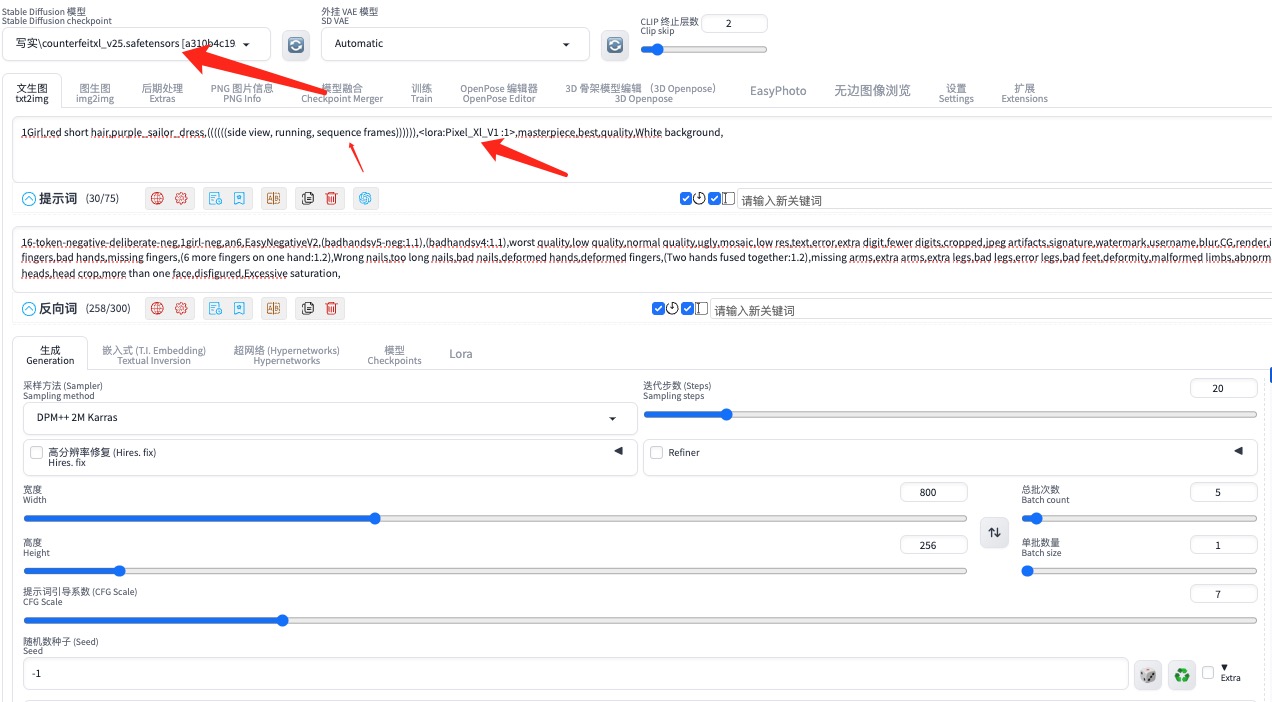

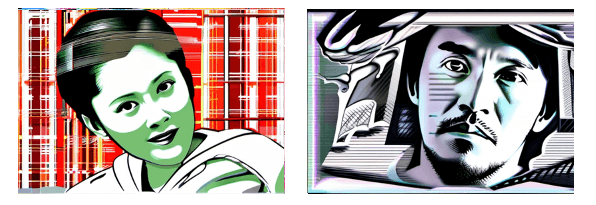

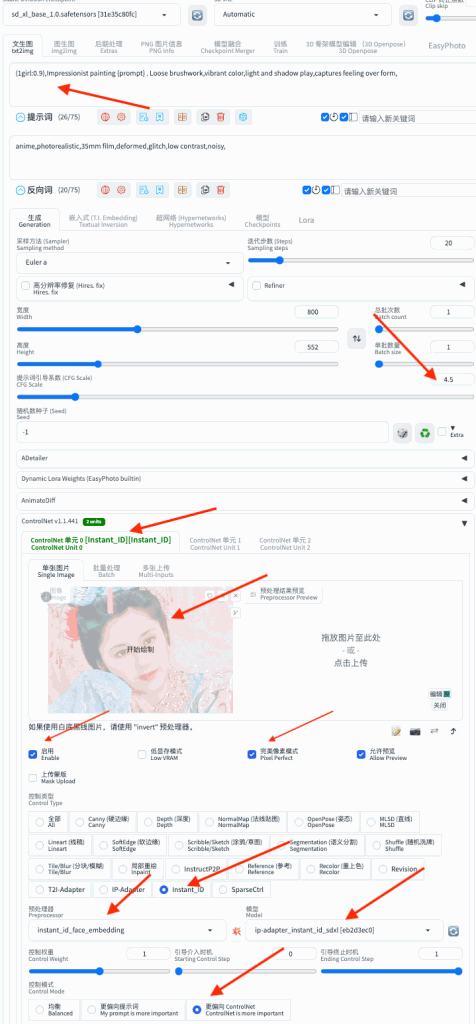

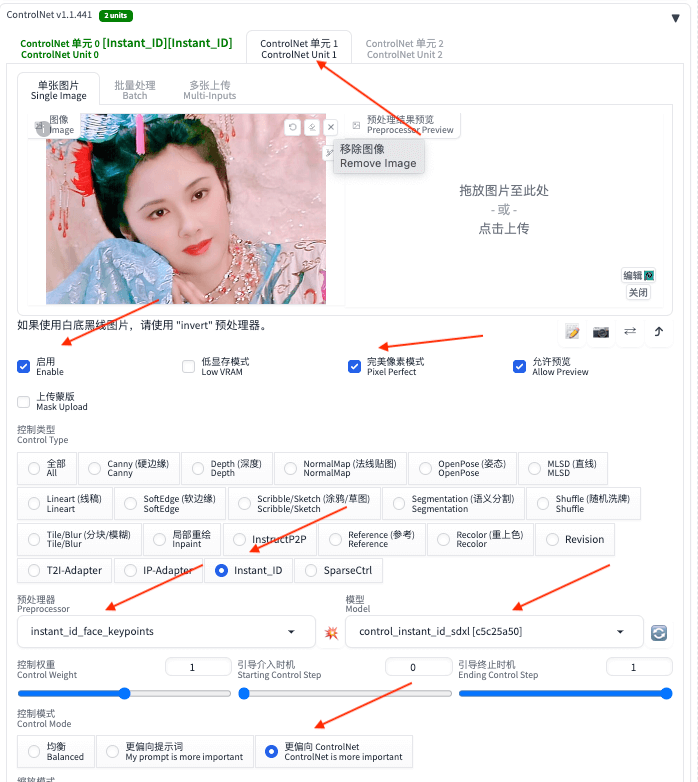

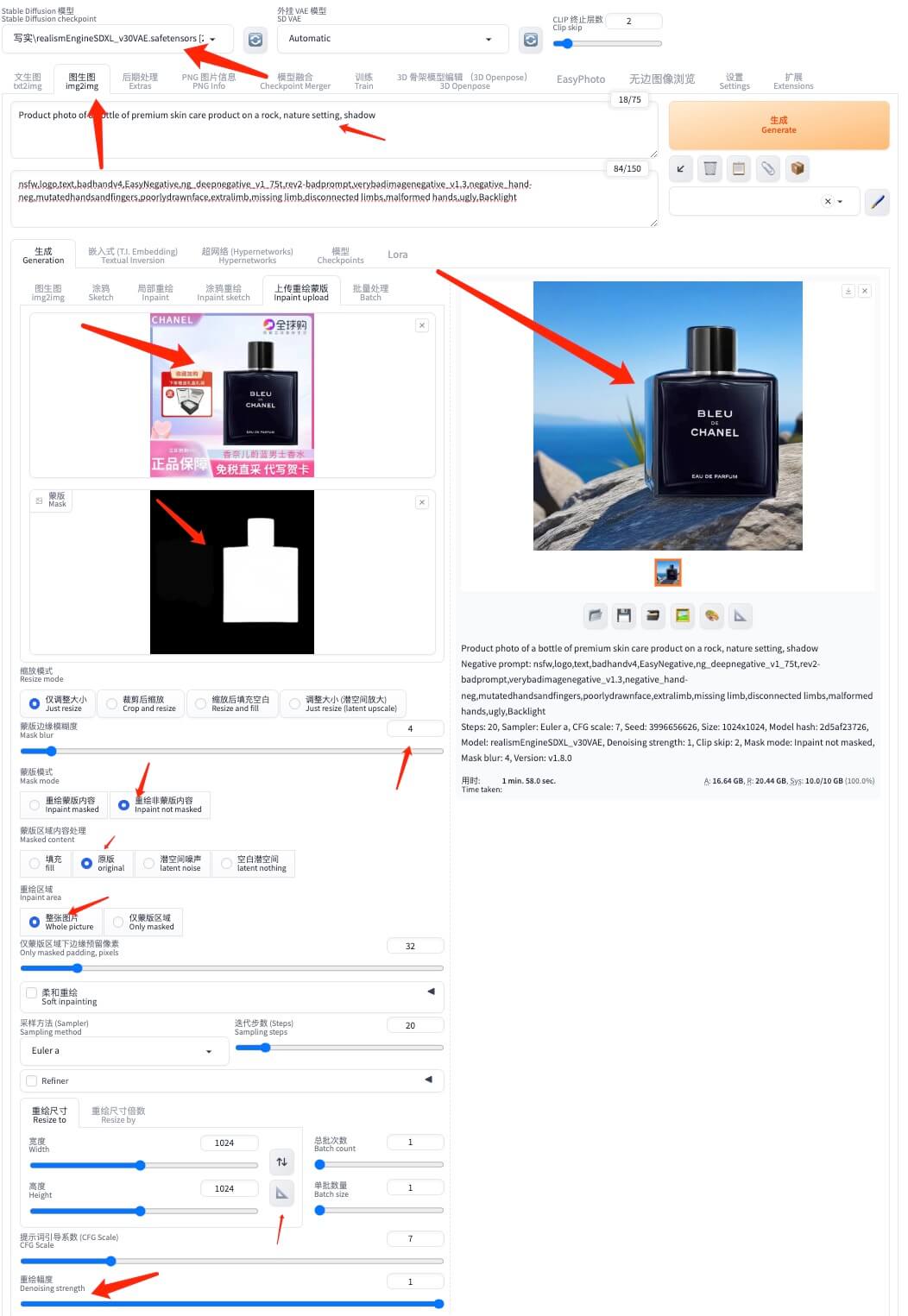

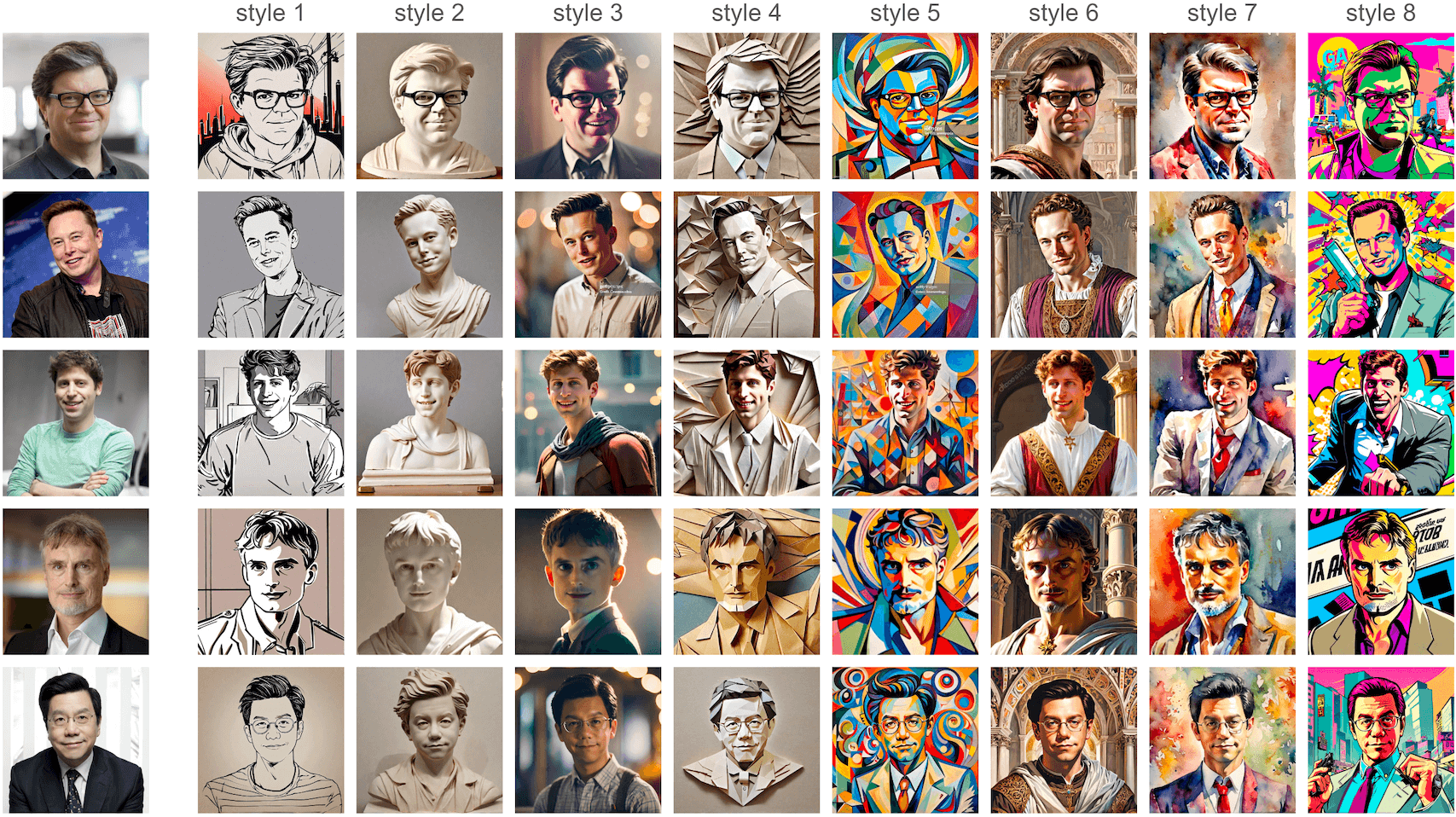

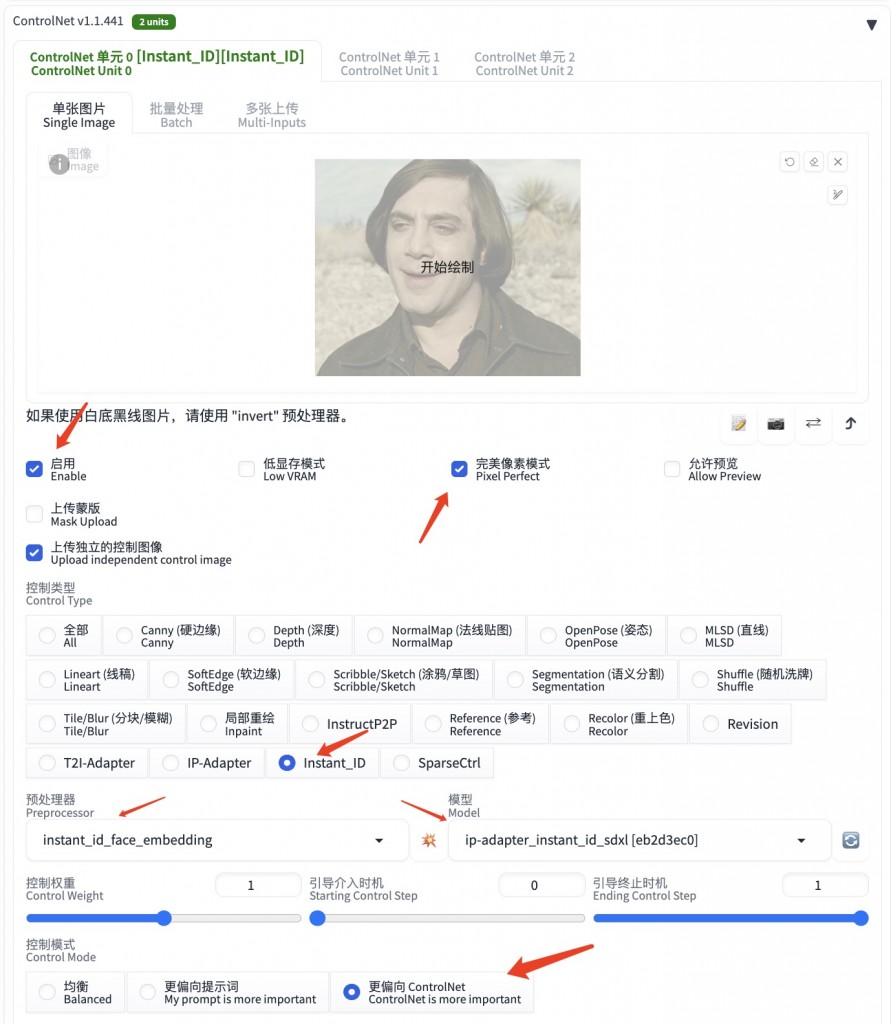

第二部,将放大后的图片导入到图生图,然后按如下方式,使用ControlNet的控制类型:Recolor

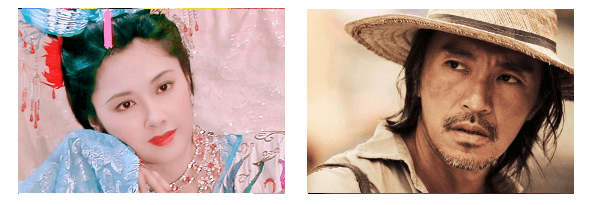

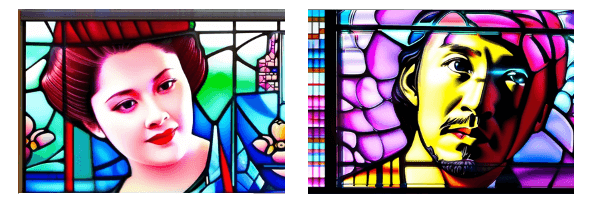

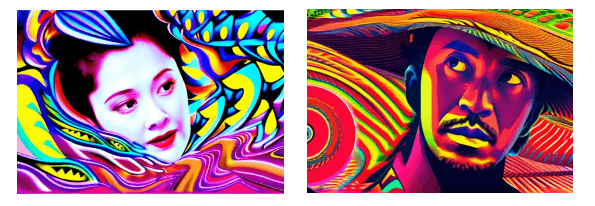

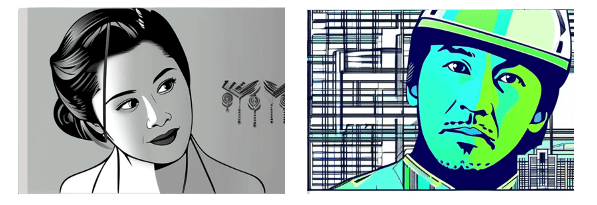

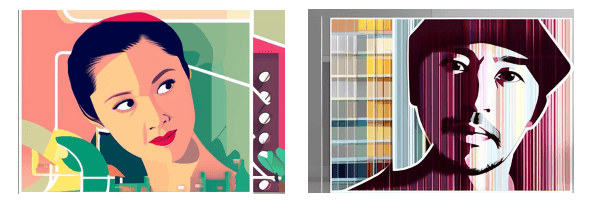

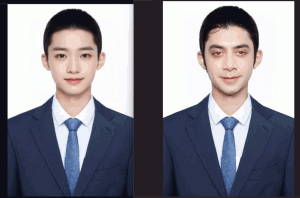

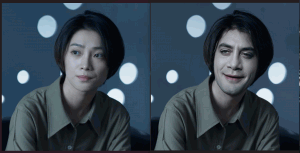

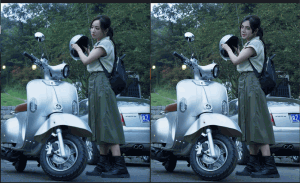

因为要上色,所以这里重绘幅度设置较大。来看一下处理前后的对比

除了上面提到的图片给放大的方法,针对模糊、褪色的老照片,还可以综合采用ControlNet的其他类型,以及脚本里的“Ultimate SD upscale”,尝试对照片做处理。手头有多年前用手机隔着相框拍的黑白旧照片,模糊、还有麻点,等我找到了修复这种照片的方法,会再写一篇blog o(* ̄︶ ̄*)o

对了,补充一下Recolor模型的下载地址:https://huggingface.co/lllyasviel/sd_control_collection/blob/main/ioclab_sd15_recolor.safetensors

——over

转载请注明出处: 昆仑的山头

时间线

- 2025 年 7 月 (2)

- 2025 年 4 月 (1)

- 2025 年 2 月 (2)

- 2024 年 12 月 (1)

- 2024 年 11 月 (1)

- 2024 年 7 月 (1)

- 2024 年 6 月 (1)

- 2024 年 5 月 (2)

- 2024 年 4 月 (3)

- 2024 年 3 月 (9)

- 2023 年 12 月 (1)

- 2023 年 11 月 (1)

- 2023 年 10 月 (1)

- 2023 年 5 月 (1)

- 2023 年 4 月 (1)

- 2022 年 12 月 (5)

- 2022 年 10 月 (1)

- 2022 年 7 月 (1)

- 2022 年 6 月 (1)

- 2022 年 3 月 (1)

- 2022 年 1 月 (3)

- 2021 年 12 月 (2)

- 2021 年 11 月 (1)

- 2021 年 10 月 (2)

- 2021 年 9 月 (1)

- 2021 年 8 月 (2)

- 2021 年 7 月 (2)

- 2021 年 6 月 (1)

- 2021 年 4 月 (2)

- 2021 年 3 月 (1)

- 2021 年 2 月 (1)

- 2020 年 12 月 (1)

- 2020 年 5 月 (2)

- 2019 年 6 月 (1)

- 2019 年 5 月 (1)

- 2018 年 8 月 (2)

- 2018 年 4 月 (1)

- 2018 年 3 月 (1)

- 2018 年 2 月 (1)

- 2017 年 11 月 (1)

- 2017 年 5 月 (1)

- 2017 年 3 月 (1)

- 2017 年 1 月 (3)

- 2016 年 9 月 (3)

- 2016 年 6 月 (2)

- 2016 年 5 月 (1)

- 2016 年 1 月 (1)

- 2015 年 10 月 (1)

- 2015 年 9 月 (1)

- 2015 年 8 月 (1)

- 2015 年 7 月 (5)

- 2015 年 4 月 (5)

- 2014 年 5 月 (1)

- 2014 年 4 月 (1)

- 2014 年 3 月 (2)

- 2014 年 2 月 (2)

- 2014 年 1 月 (7)

- 2013 年 11 月 (1)

- 2013 年 9 月 (2)

- 2013 年 7 月 (3)

- 2013 年 6 月 (1)

- 2013 年 5 月 (3)

- 2013 年 4 月 (3)

- 2013 年 2 月 (3)

- 2013 年 1 月 (10)

- 2012 年 12 月 (3)

- 2012 年 11 月 (2)

- 2012 年 10 月 (3)

- 2012 年 9 月 (3)

- 2012 年 8 月 (1)

- 2012 年 7 月 (7)

- 2012 年 6 月 (5)

- 2012 年 5 月 (7)

- 2012 年 4 月 (3)

- 2012 年 3 月 (4)

- 2012 年 2 月 (8)

- 2012 年 1 月 (9)

- 2011 年 12 月 (3)

- 2011 年 11 月 (4)

- 2011 年 10 月 (5)

- 2011 年 9 月 (3)

- 2011 年 8 月 (5)

- 2011 年 5 月 (1)

- 2011 年 4 月 (5)

- 2011 年 3 月 (11)

- 2011 年 2 月 (6)

- 2010 年 12 月 (1)

- 2009 年 9 月 (1)

- 2009 年 8 月 (1)

- 2009 年 7 月 (1)

- 2008 年 12 月 (2)

- 2008 年 11 月 (4)

- 2008 年 10 月 (4)

七嘴八舌

- 123 发表在《[转]在ios模拟器上实现模拟双指触摸》

- admin 发表在《nodejs-express初体验》

- laozh 发表在《nodejs-express初体验》

- xxx 发表在《玩转微信公号开发(七)——账号体系与oauth登录》

- 银基网 发表在《玩转微信公号开发(七)——账号体系与oauth登录》

发布日历

2026 年 2 月 一 二 三 四 五 六 日 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28

关于本站

关于本站