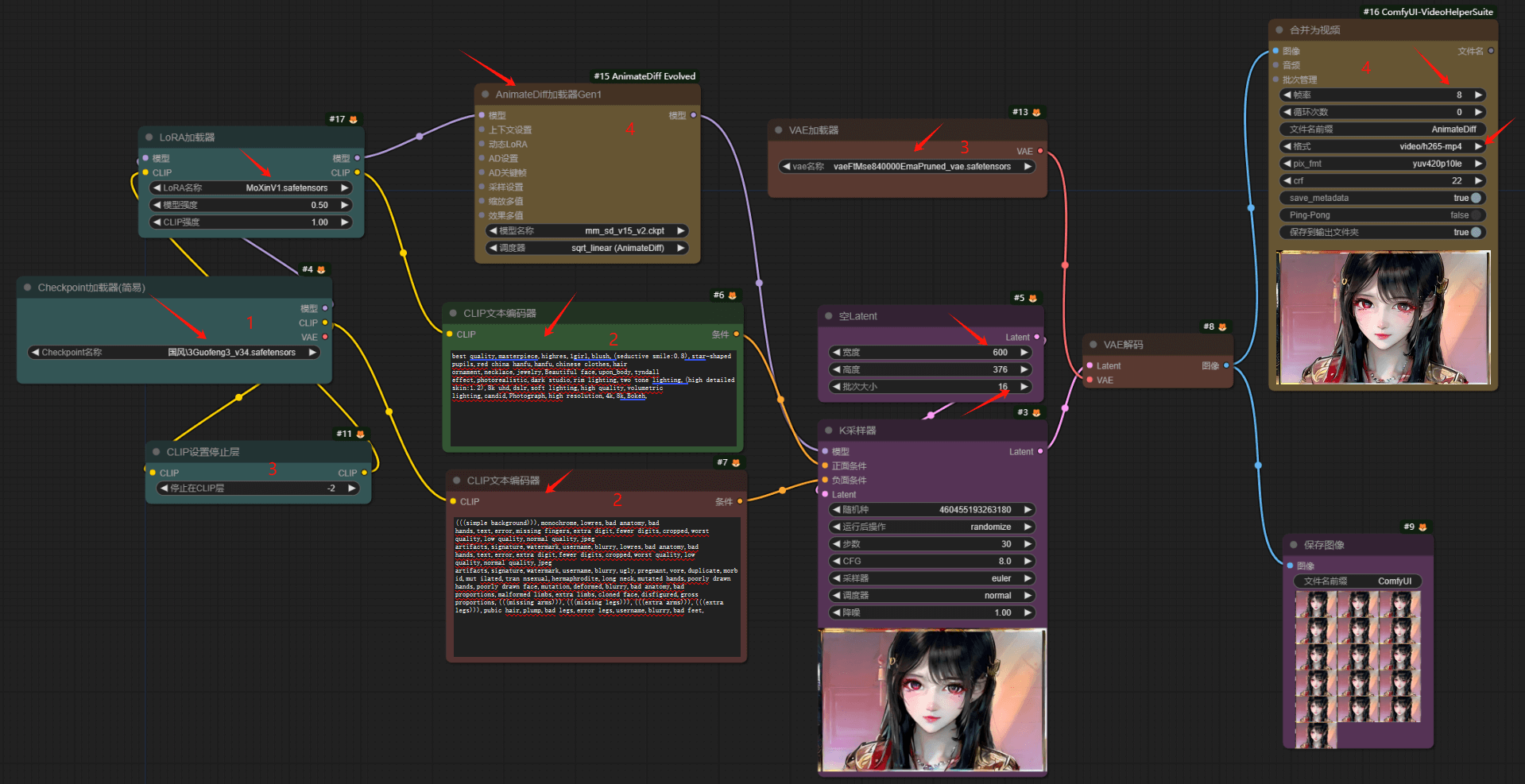

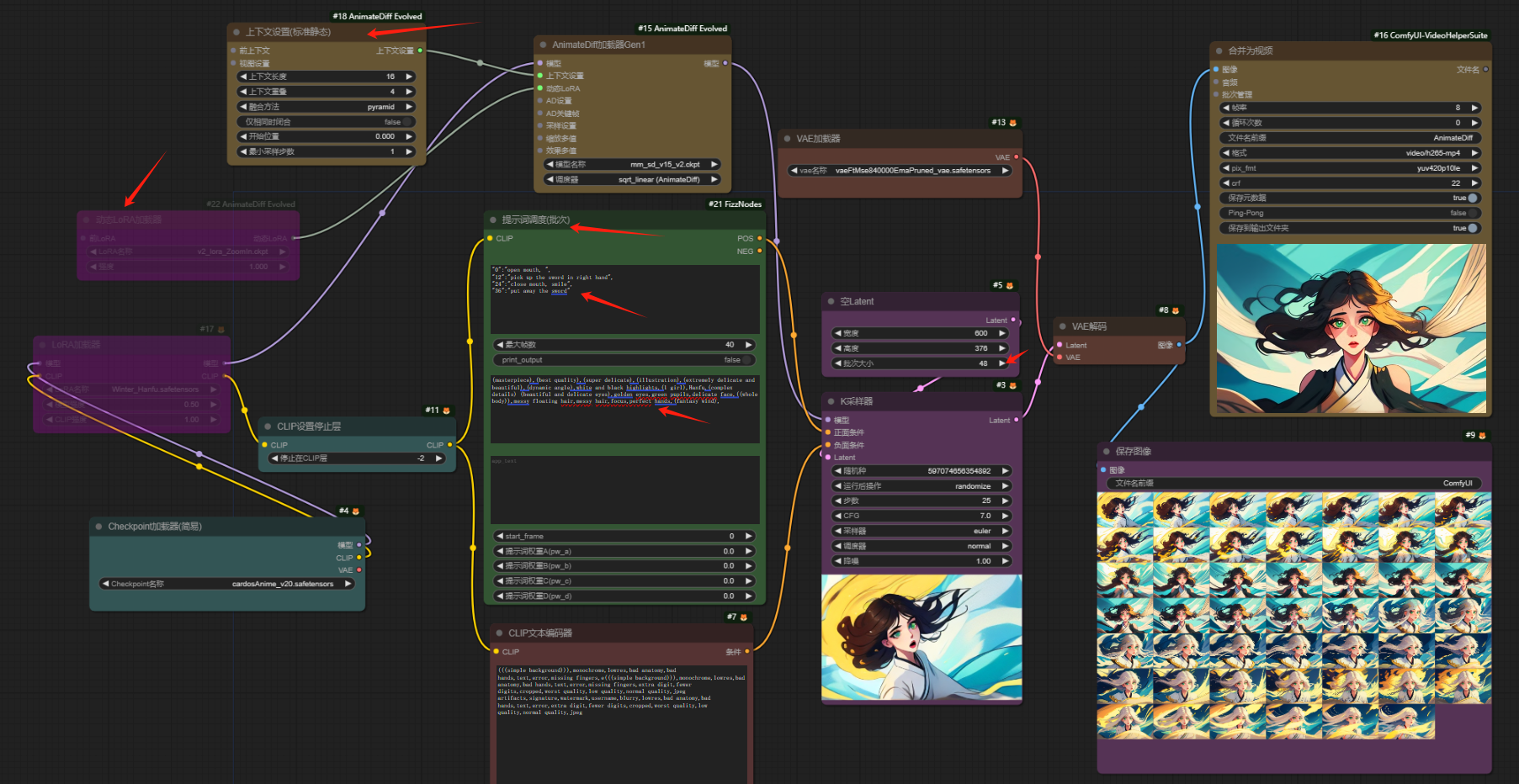

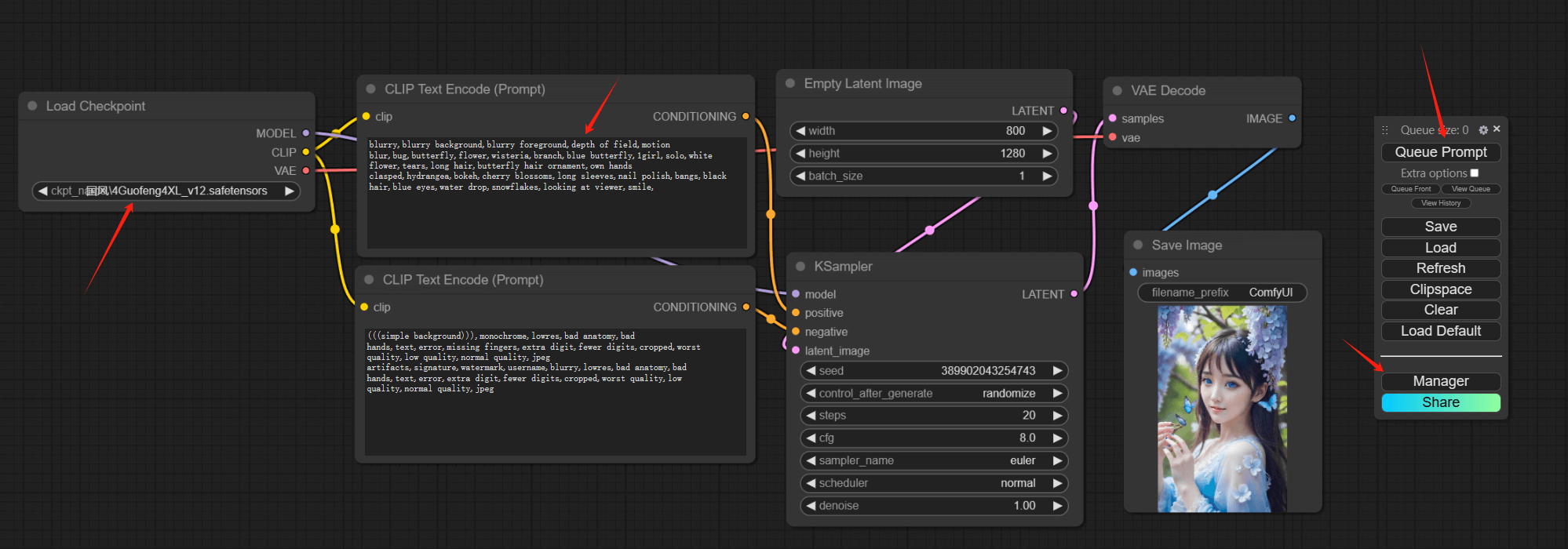

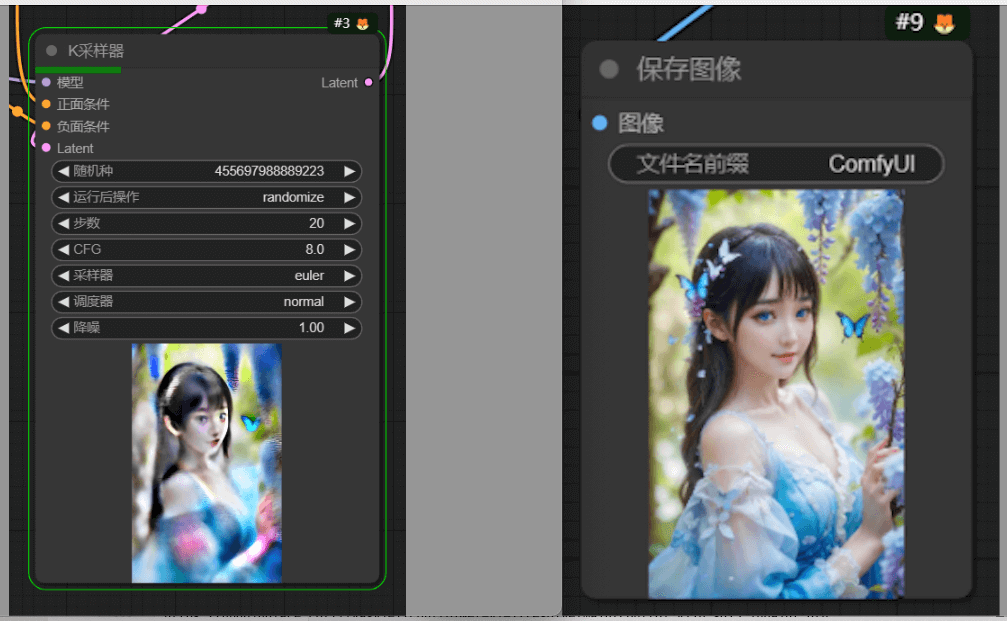

今天来介绍一个ComfyUI-Flux的换装工作流。和ComfyUI示例里自带的类似功能工作流相比,此工作流增加了一个“PaintEditor”节点,作用是可以用画笔圈出说要修改的部位,这样可以让ComfyUI做出更精确的修改,同时又尽可能的保留原图其他部分的状态,话不多说,我们先来看一下实际的效果:

(提示词:Change the clothing in the red-framed area to Leopard print skirt everything else in the image exactly the same, including all other people, background, poses, and facial features.)

可以看出,除了提示词要求的修改短裙,包括模特的面部表情、姿势在内的整张图的其他部分均未改变,甚至面部阴影也没有变化。

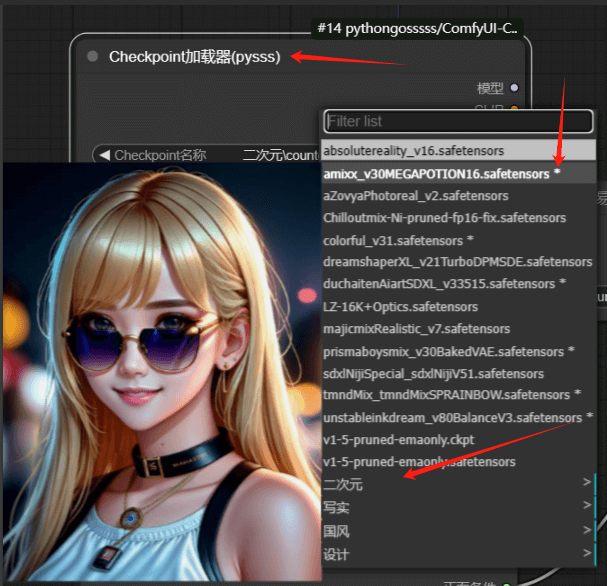

关于PaintEditor节点,安装地址:https://github.com/Pixelailabs/paint_editor。关键步骤:点击paint_editor节点里的“open paint editor”按钮,并用红笔圈出要修改的部分

如上图,除了修改服装,这个工作流还可以修改图片中的其他元素,比如:

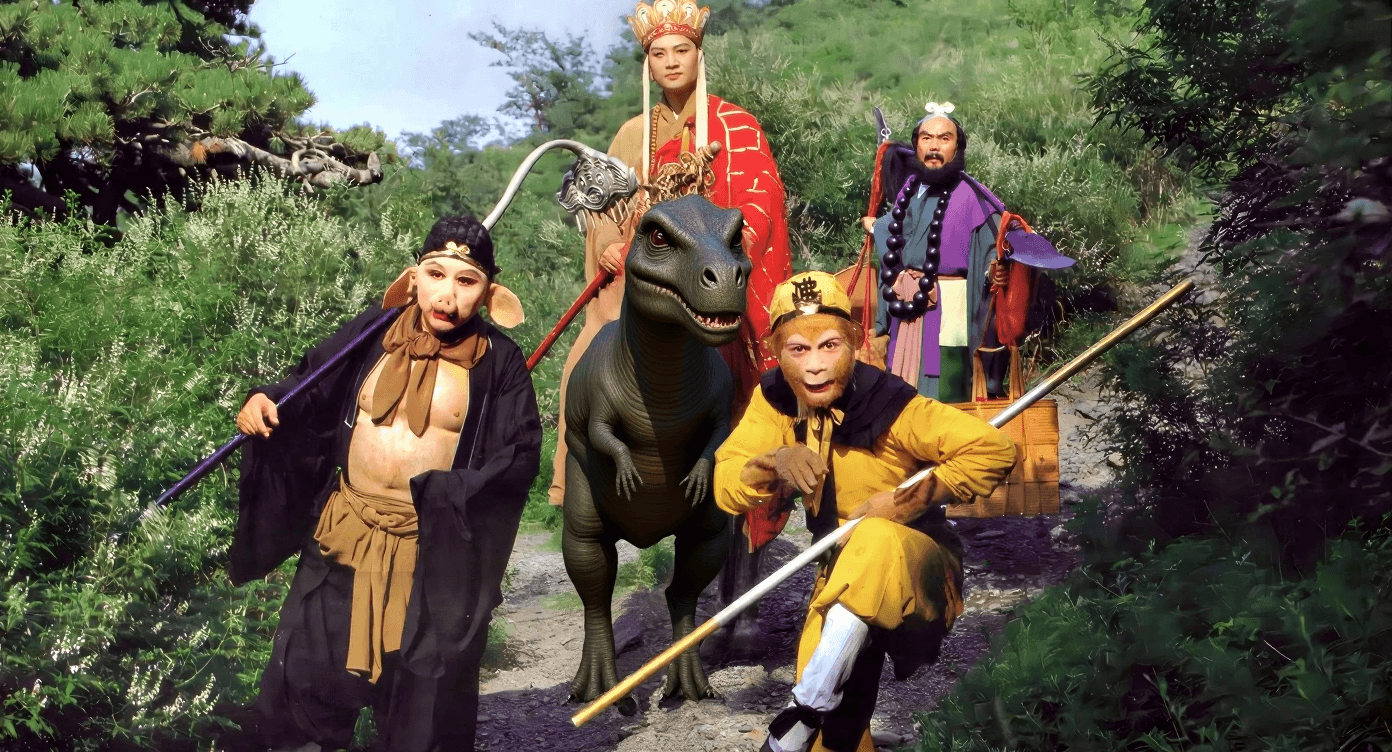

(提示词:Change the horse in the red-framed area to the Ostrich …)

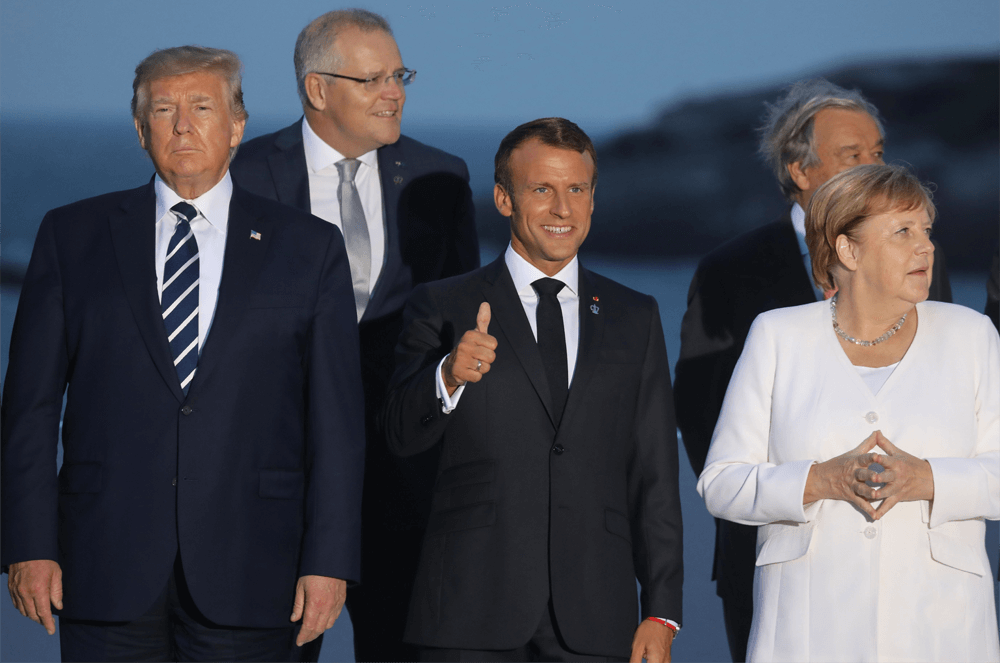

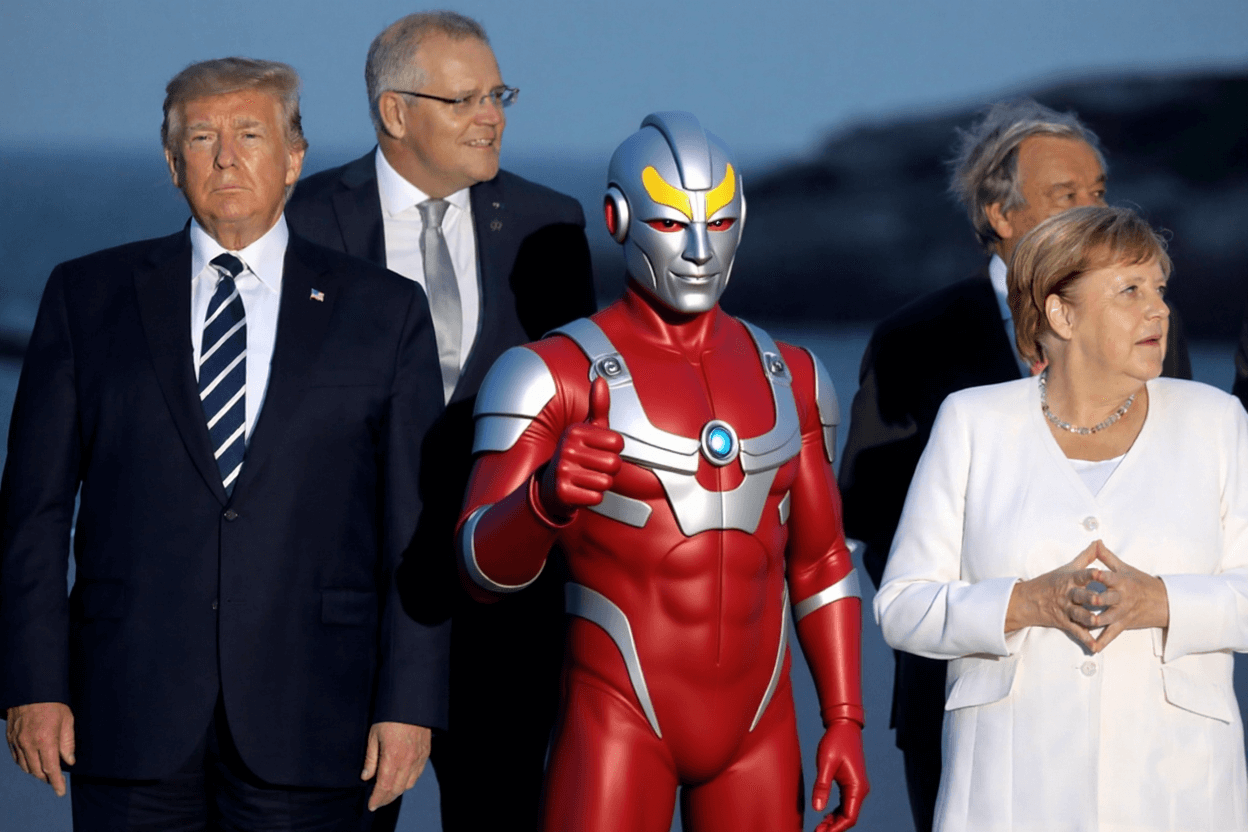

(提示词:Change the character in the red-framed area to the Ultraman…)

——

over

转载请注明出处:http://www.jiangkl.com/2025/07/aigc_comfyui_flux_change_clothes/

关于本站

关于本站