EasyPhoto是一个集模型训练、文生图、图生图、文生视频、图生视频于一体的SD插件,功能强大,操作简便,今天就来看看如果用它来做AI换脸。

安装好EasyPhoto以后,SD的webui的上导航就会出现EasyPhoto选项卡,点进去以后,默认就是“训练”Lora的界面。这里可以选择不少于5张面部图片,尽量包含各种表情、各种角度。我们就来请出一位和蔼可亲的大叔来做模特,把图片上传到“训练”内

右边“高级选项”中,选择“人物Lora”、选一个比较通用的写实大模型。“max train steps”和“max steps per photos”,分别是训练步数,和每张图片训练多少次,如果不想训练过程太久,可以保持默认选项,下面的验证选项“Validation”建议取消勾选,否则不仅训练过程会变慢,而且还很容易报错、中断训练过程。ok,点击橙色的“Start Training”按钮,输入Lora名称,开始训练

16张图,按上图的设置,手头这台电脑显卡是10G3080,训练时间大概是20~30分钟

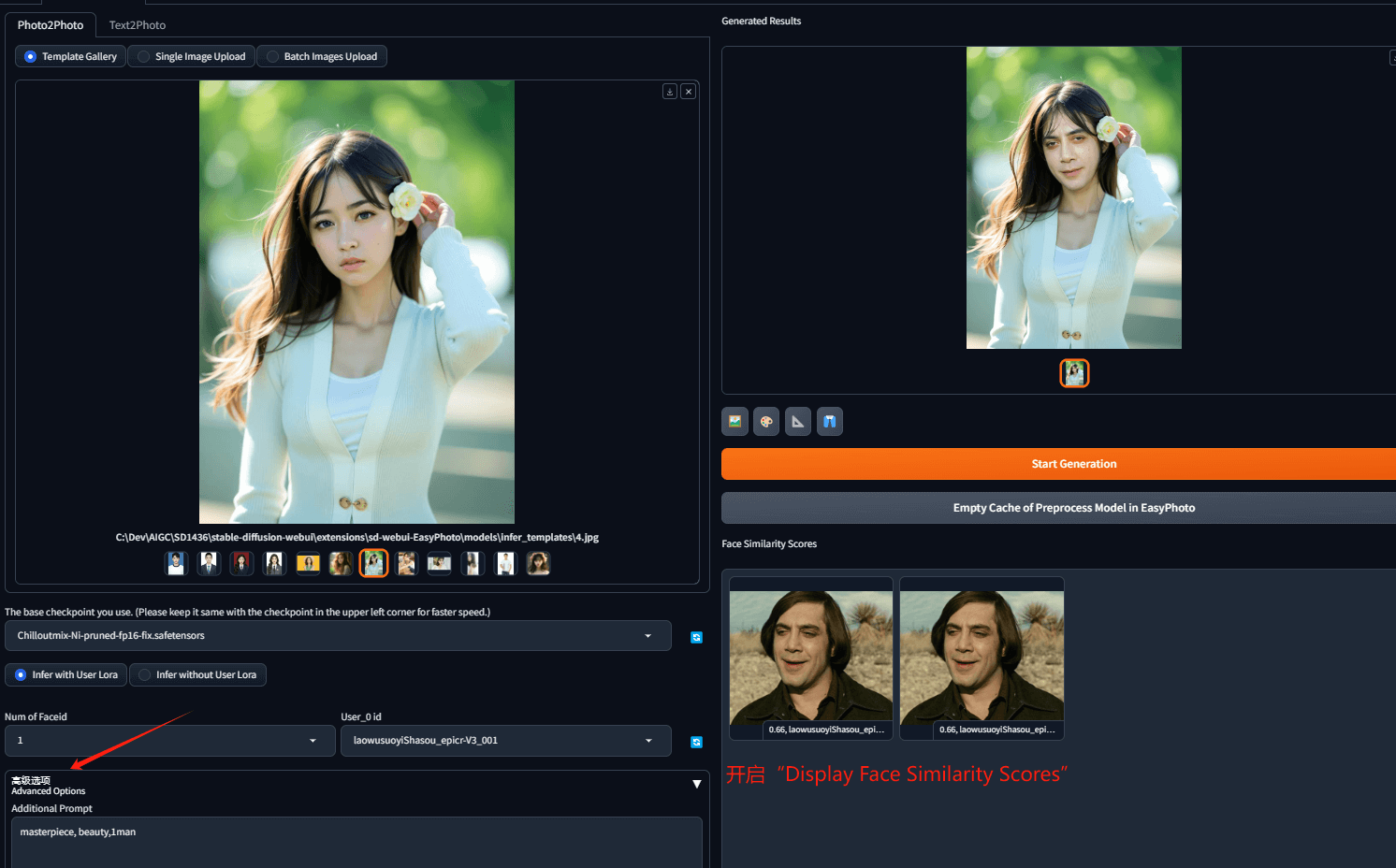

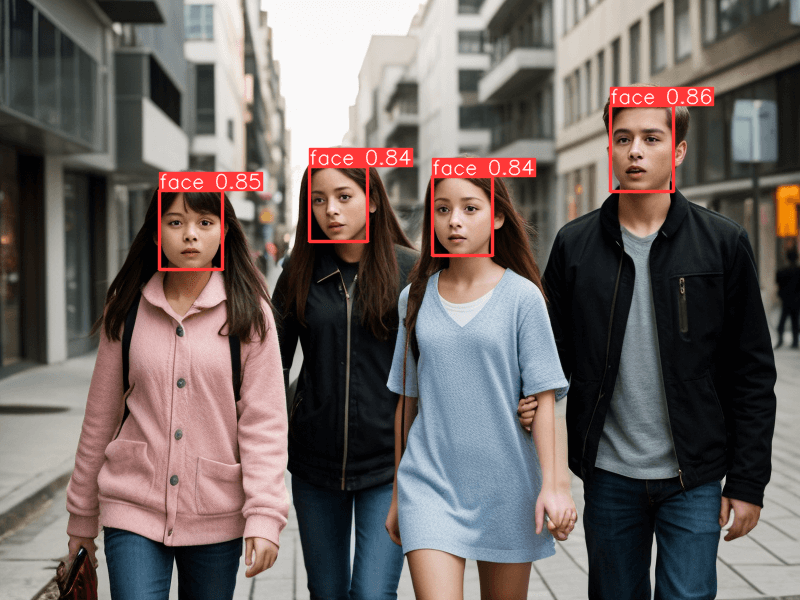

~~训练完成,切换到“Photo Inference”选项,测试一下训练效果。先使用“Photo2Photo – Template Gallery”,选一张easyphoto自带的模版图片,下侧大模型,尽量和训练Lora时保持一致,Num of Faceid选1,user_0 id选择刚才训练的Lora(如果没有,点一下右侧的刷新按钮),点击橙色按钮,稍等片刻,既可以看到换脸效果

下方“高级选项”,可输入更多提示词,对输出结果进行更多调整。勾选选择“Display Face Similarity Scores”,可以看到当前输出结果,是参考自哪张训练图。

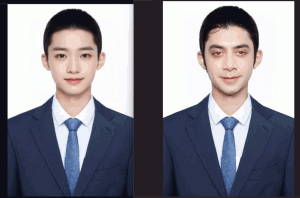

换一种同性别的证件照:

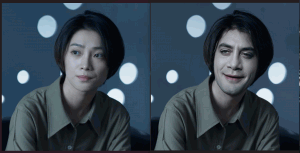

可以看出easyphoto并非简单换脸,而是会做一定程度的融合,具体的融合参数,可通过“高级选项”进行设置。

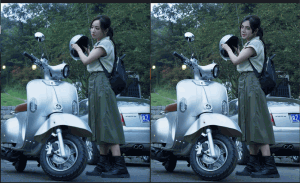

切换到“Sing Image Upload”,上传几张自定义图片试试效果:

另外试了一下easyphoto的图生视频选项,效果很渣,等调整好了,再拿出来展示o(* ̄︶ ̄*)o

——over

转载请注明出处: 昆仑的山头

时间线

- 2025 年四月 (1)

- 2025 年二月 (2)

- 2024 年十二月 (1)

- 2024 年十一月 (1)

- 2024 年七月 (1)

- 2024 年六月 (1)

- 2024 年五月 (2)

- 2024 年四月 (3)

- 2024 年三月 (9)

- 2023 年十二月 (1)

- 2023 年十一月 (1)

- 2023 年十月 (1)

- 2023 年五月 (1)

- 2023 年四月 (1)

- 2022 年十二月 (5)

- 2022 年十月 (1)

- 2022 年七月 (1)

- 2022 年六月 (1)

- 2022 年三月 (1)

- 2022 年一月 (3)

- 2021 年十二月 (2)

- 2021 年十一月 (1)

- 2021 年十月 (2)

- 2021 年九月 (1)

- 2021 年八月 (2)

- 2021 年七月 (2)

- 2021 年六月 (1)

- 2021 年四月 (2)

- 2021 年三月 (1)

- 2021 年二月 (1)

- 2020 年十二月 (1)

- 2020 年五月 (2)

- 2019 年六月 (1)

- 2019 年五月 (1)

- 2018 年八月 (2)

- 2018 年四月 (1)

- 2018 年三月 (1)

- 2018 年二月 (1)

- 2017 年十一月 (1)

- 2017 年五月 (1)

- 2017 年三月 (1)

- 2017 年一月 (3)

- 2016 年九月 (3)

- 2016 年六月 (2)

- 2016 年五月 (1)

- 2016 年一月 (1)

- 2015 年十月 (1)

- 2015 年九月 (1)

- 2015 年八月 (1)

- 2015 年七月 (5)

- 2015 年四月 (5)

- 2014 年五月 (1)

- 2014 年四月 (1)

- 2014 年三月 (2)

- 2014 年二月 (2)

- 2014 年一月 (7)

- 2013 年十一月 (1)

- 2013 年九月 (2)

- 2013 年七月 (3)

- 2013 年六月 (1)

- 2013 年五月 (3)

- 2013 年四月 (3)

- 2013 年二月 (3)

- 2013 年一月 (10)

- 2012 年十二月 (3)

- 2012 年十一月 (2)

- 2012 年十月 (3)

- 2012 年九月 (3)

- 2012 年八月 (1)

- 2012 年七月 (7)

- 2012 年六月 (5)

- 2012 年五月 (7)

- 2012 年四月 (3)

- 2012 年三月 (4)

- 2012 年二月 (8)

- 2012 年一月 (9)

- 2011 年十二月 (3)

- 2011 年十一月 (4)

- 2011 年十月 (5)

- 2011 年九月 (3)

- 2011 年八月 (5)

- 2011 年五月 (1)

- 2011 年四月 (5)

- 2011 年三月 (11)

- 2011 年二月 (6)

- 2010 年十二月 (1)

- 2009 年九月 (1)

- 2009 年八月 (1)

- 2009 年七月 (1)

- 2008 年十二月 (2)

- 2008 年十一月 (4)

- 2008 年十月 (4)

七嘴八舌

- 123 发表在《[转]在ios模拟器上实现模拟双指触摸》

- admin 发表在《nodejs-express初体验》

- laozh 发表在《nodejs-express初体验》

- xxx 发表在《玩转微信公号开发(七)——账号体系与oauth登录》

- 银基网 发表在《玩转微信公号开发(七)——账号体系与oauth登录》

关于本站

关于本站