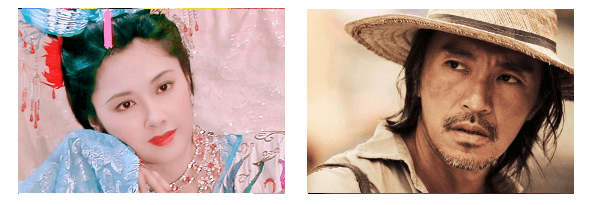

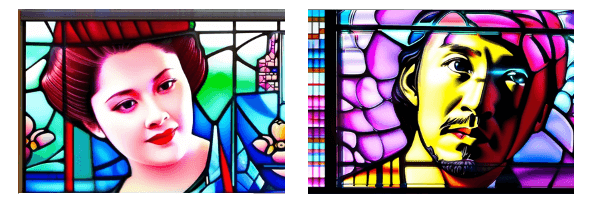

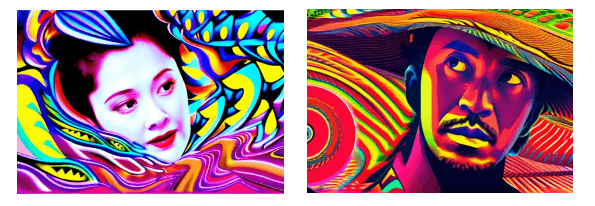

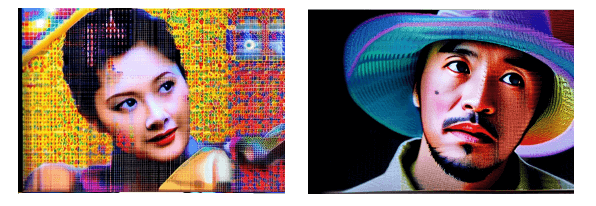

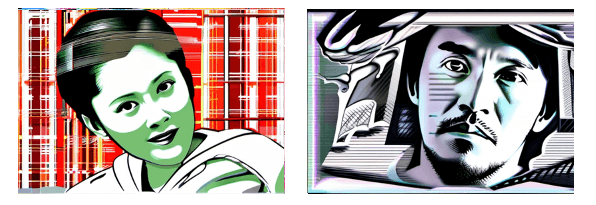

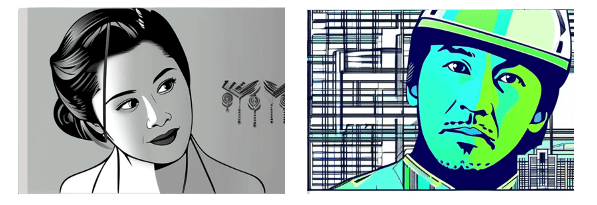

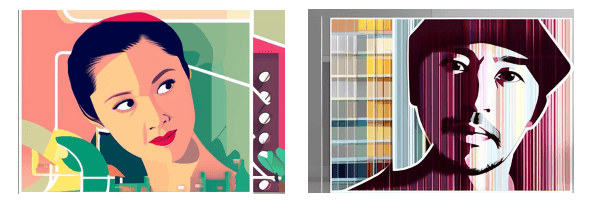

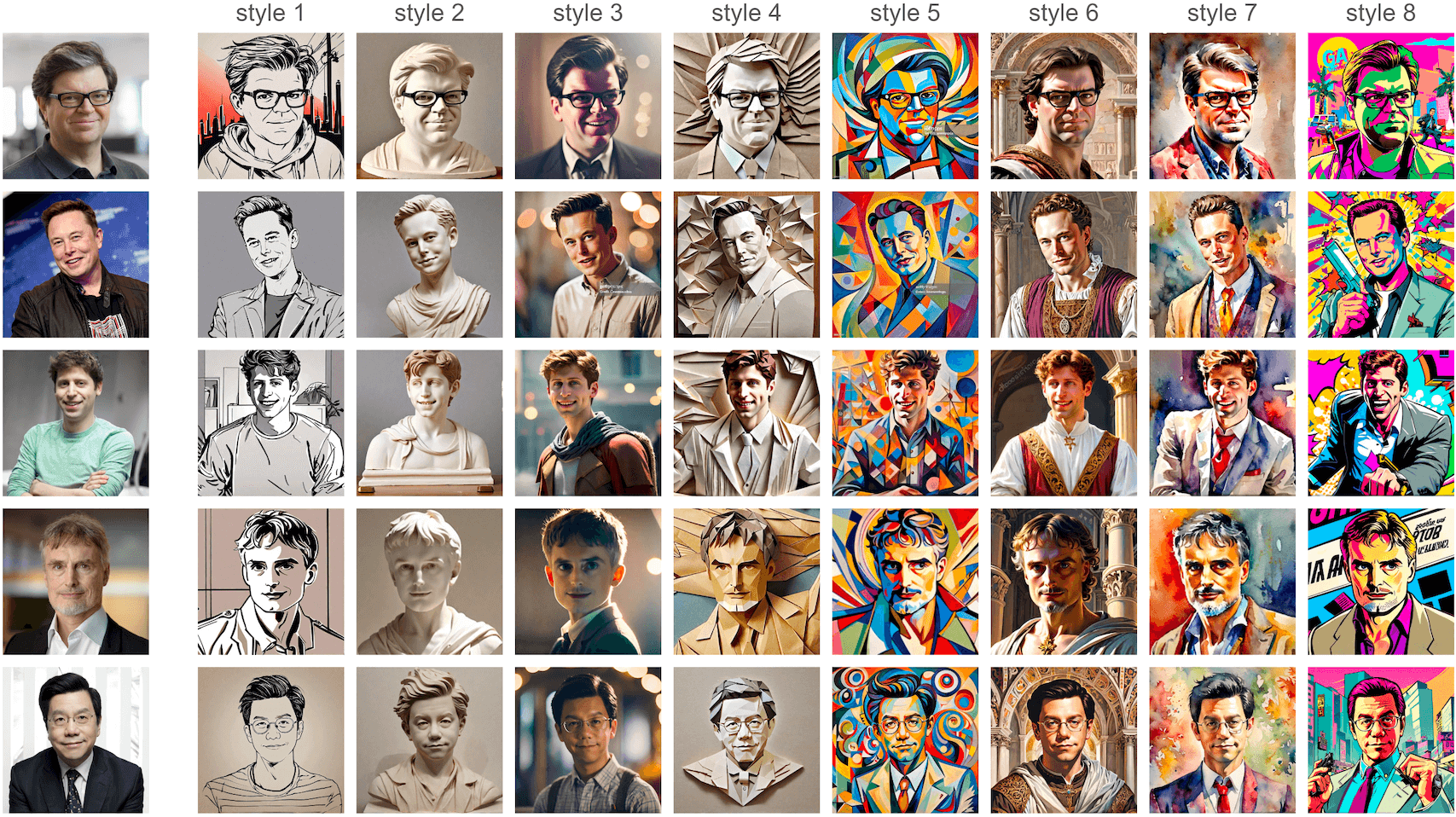

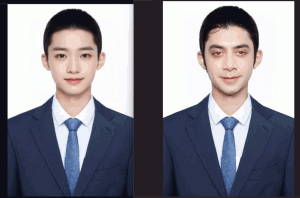

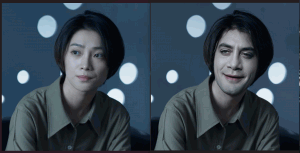

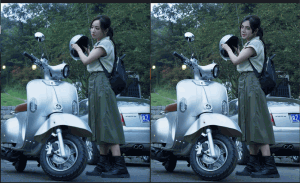

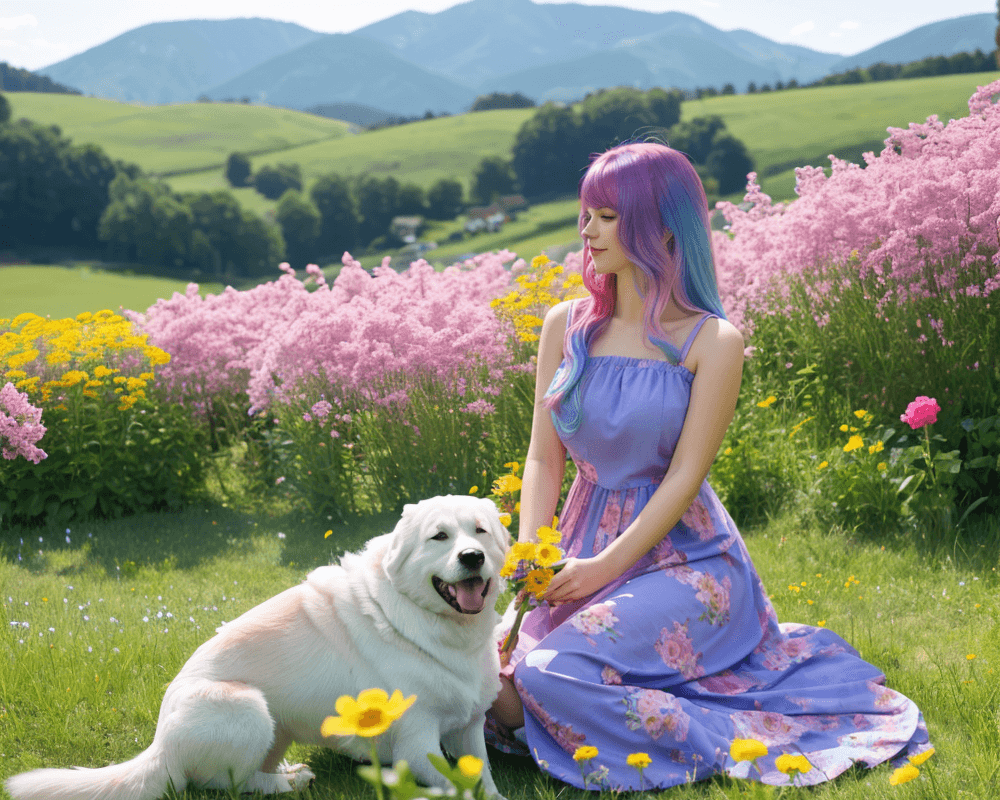

上次提到使用InstantId做换脸,这次就试试其官方突出推广的“风格化照片”功能,先来看看成果,第一组是原图,下面是各种风格转化效果

有点感觉吧~~有几个其实并不理想,如果多跑几张,应该会有更好的效果,无奈InstantId对显存要求很高,我的10G显卡跑着有点吃力,每张图基本都要5-10分钟以上(⊙o⊙)…

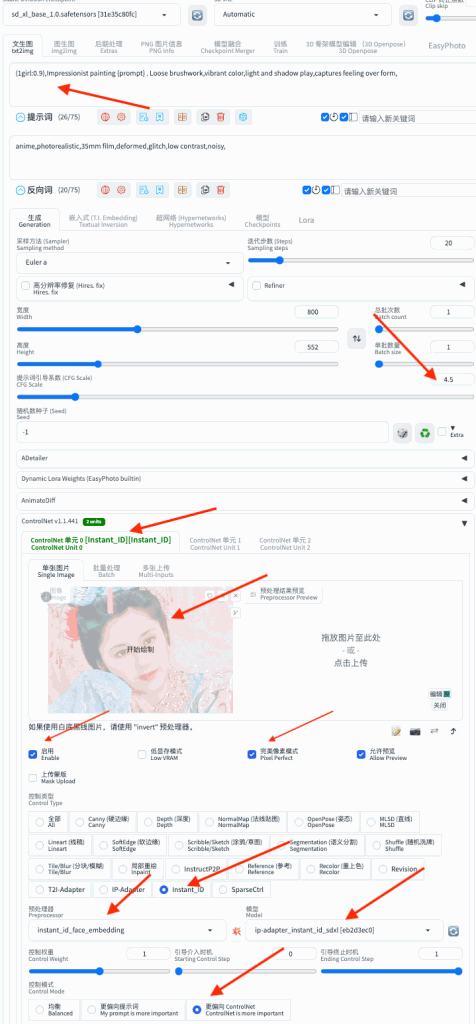

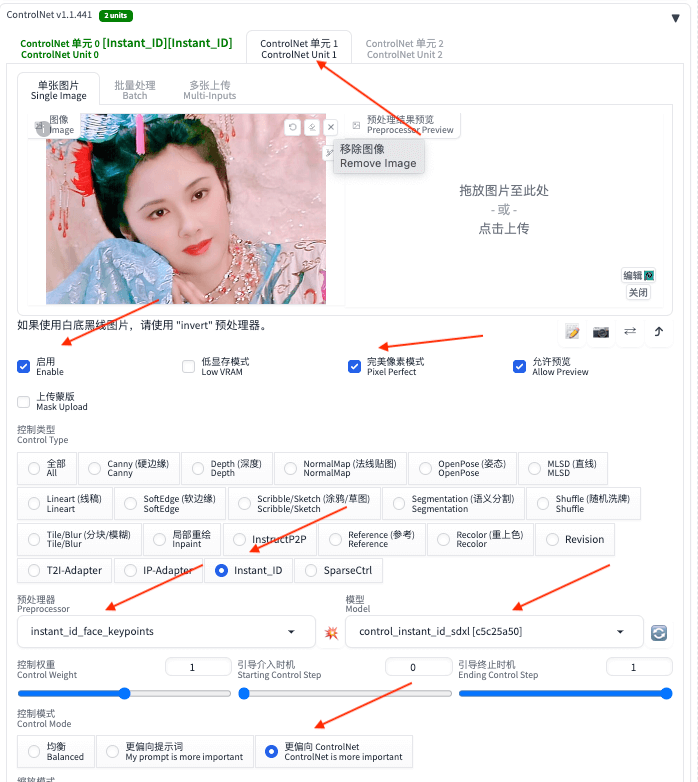

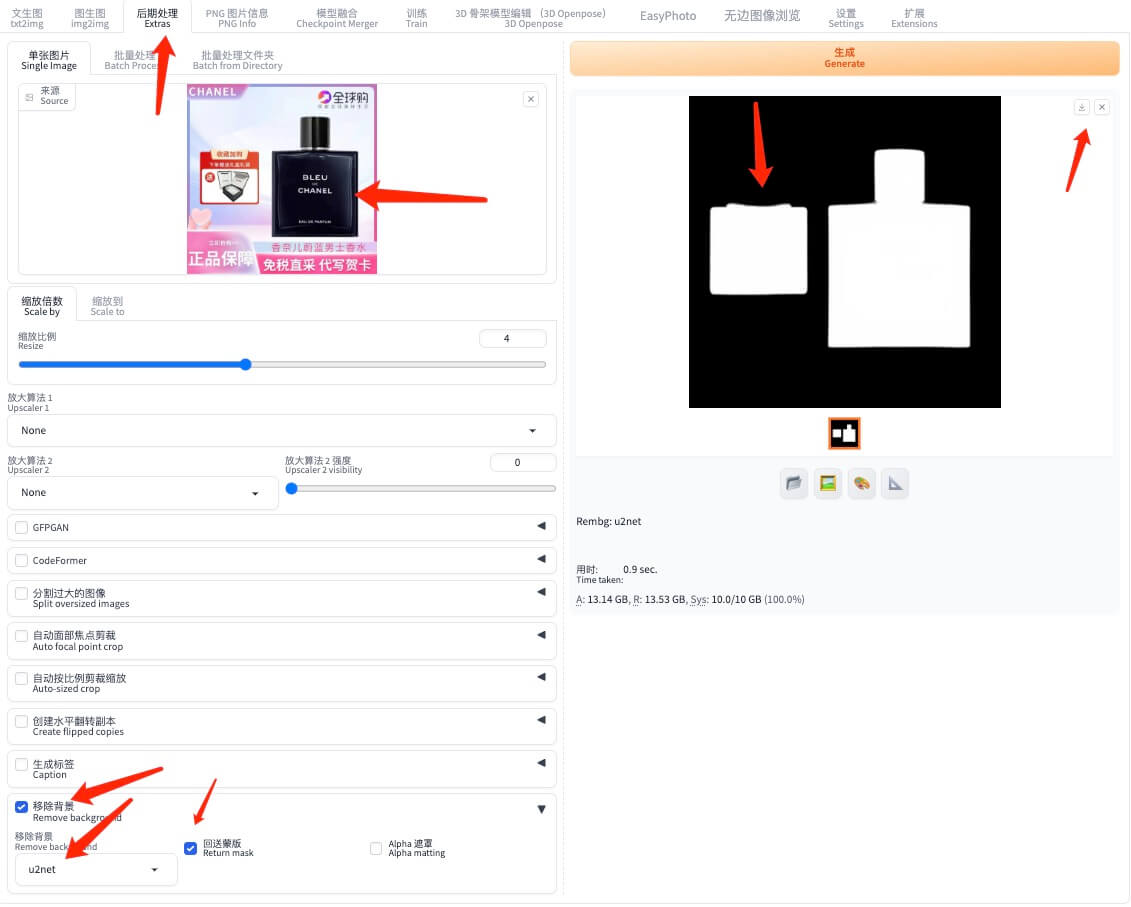

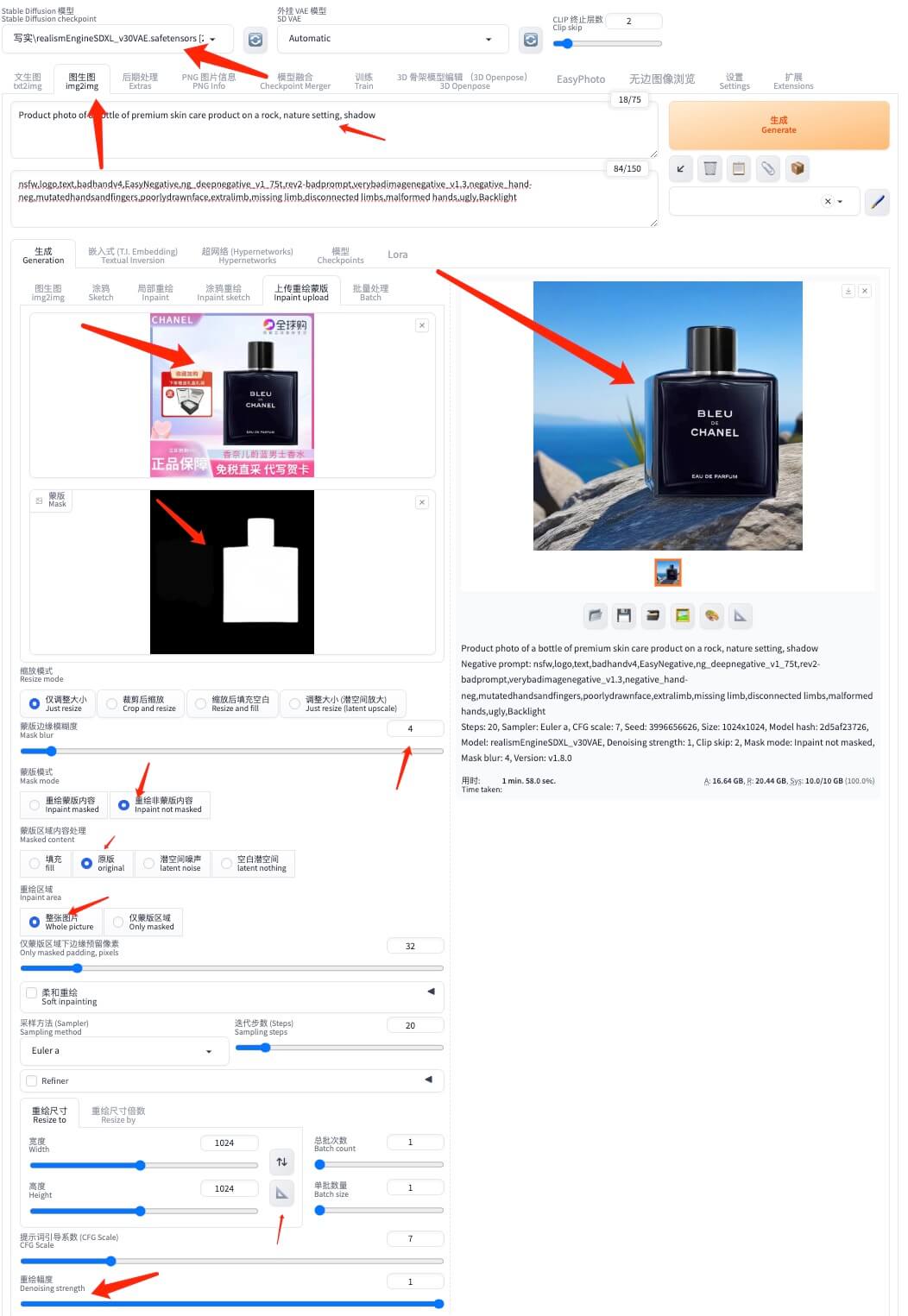

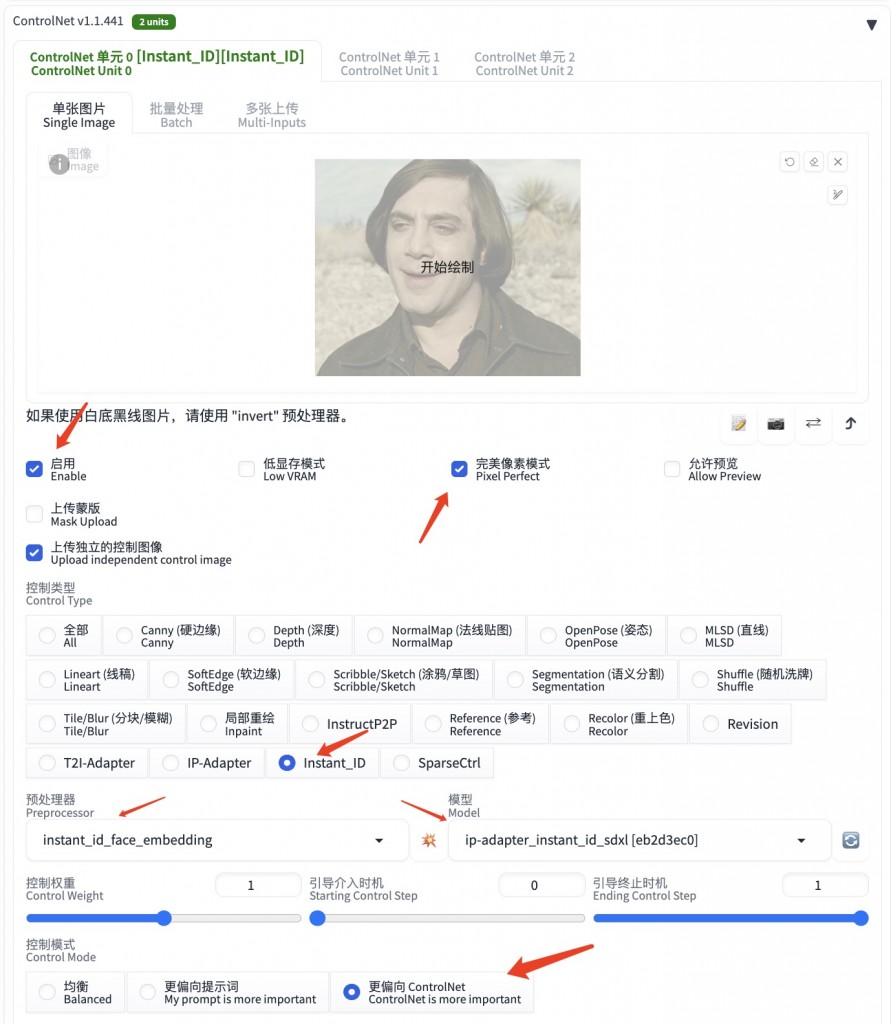

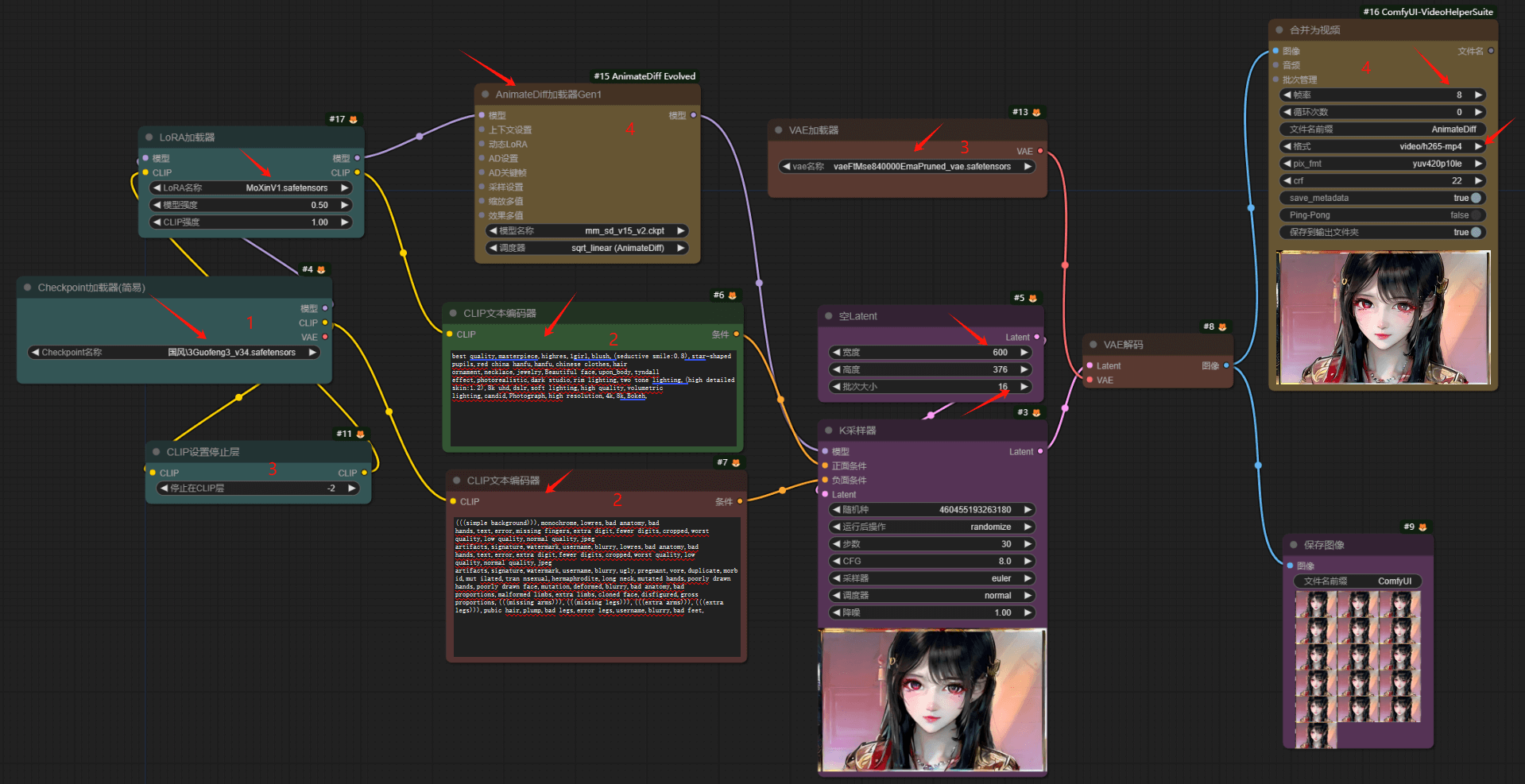

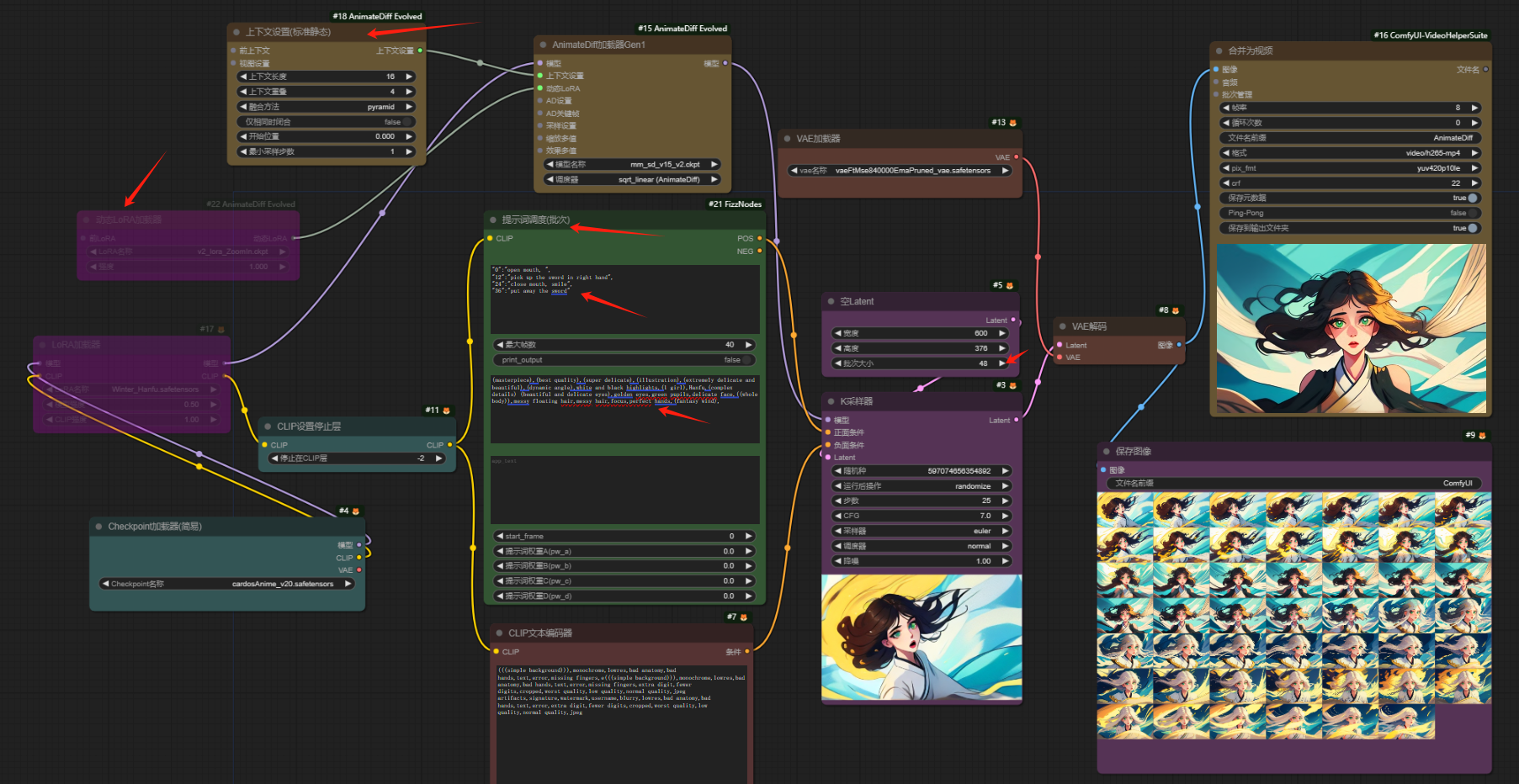

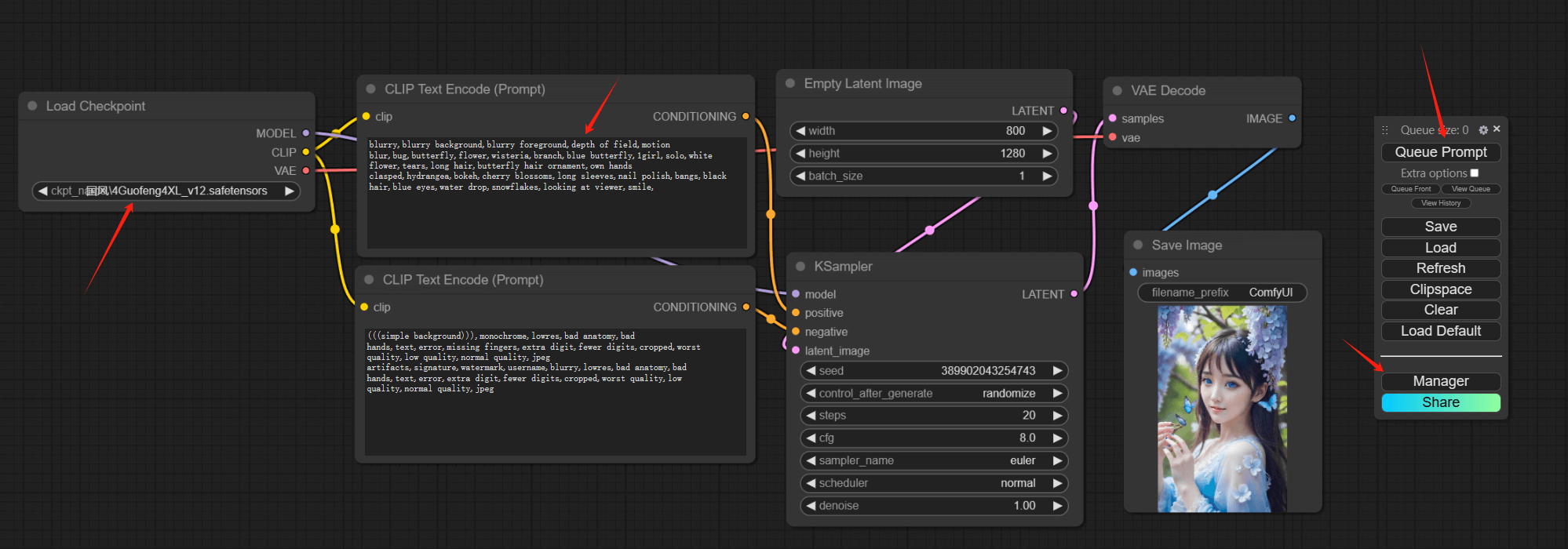

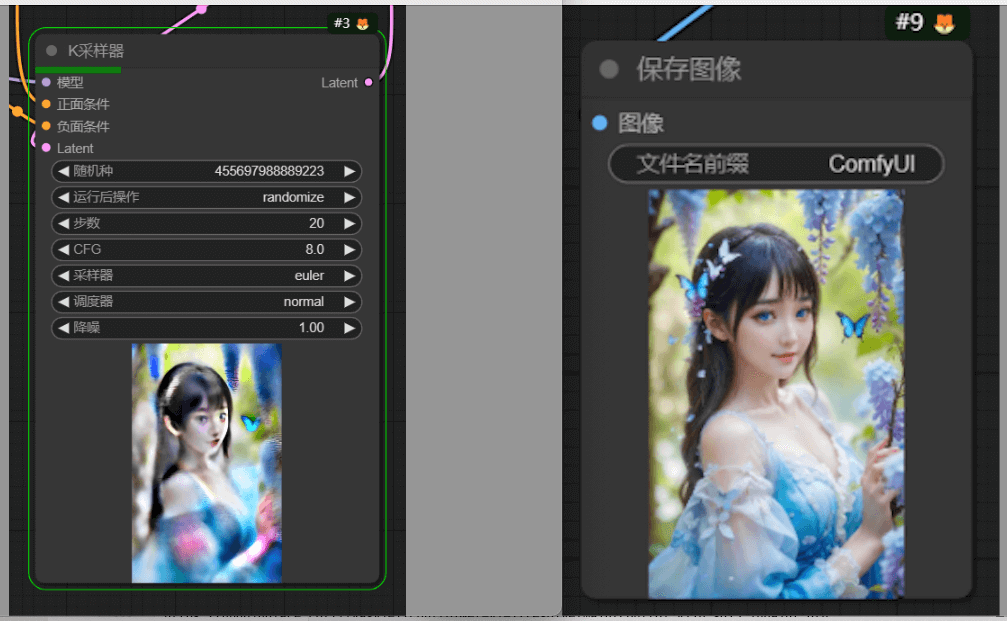

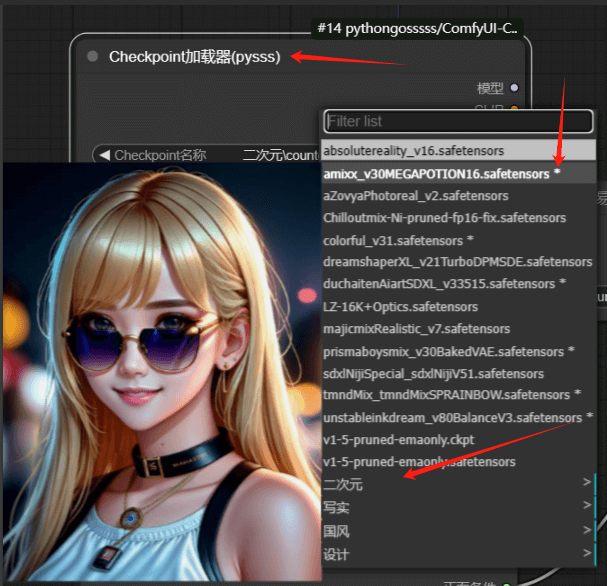

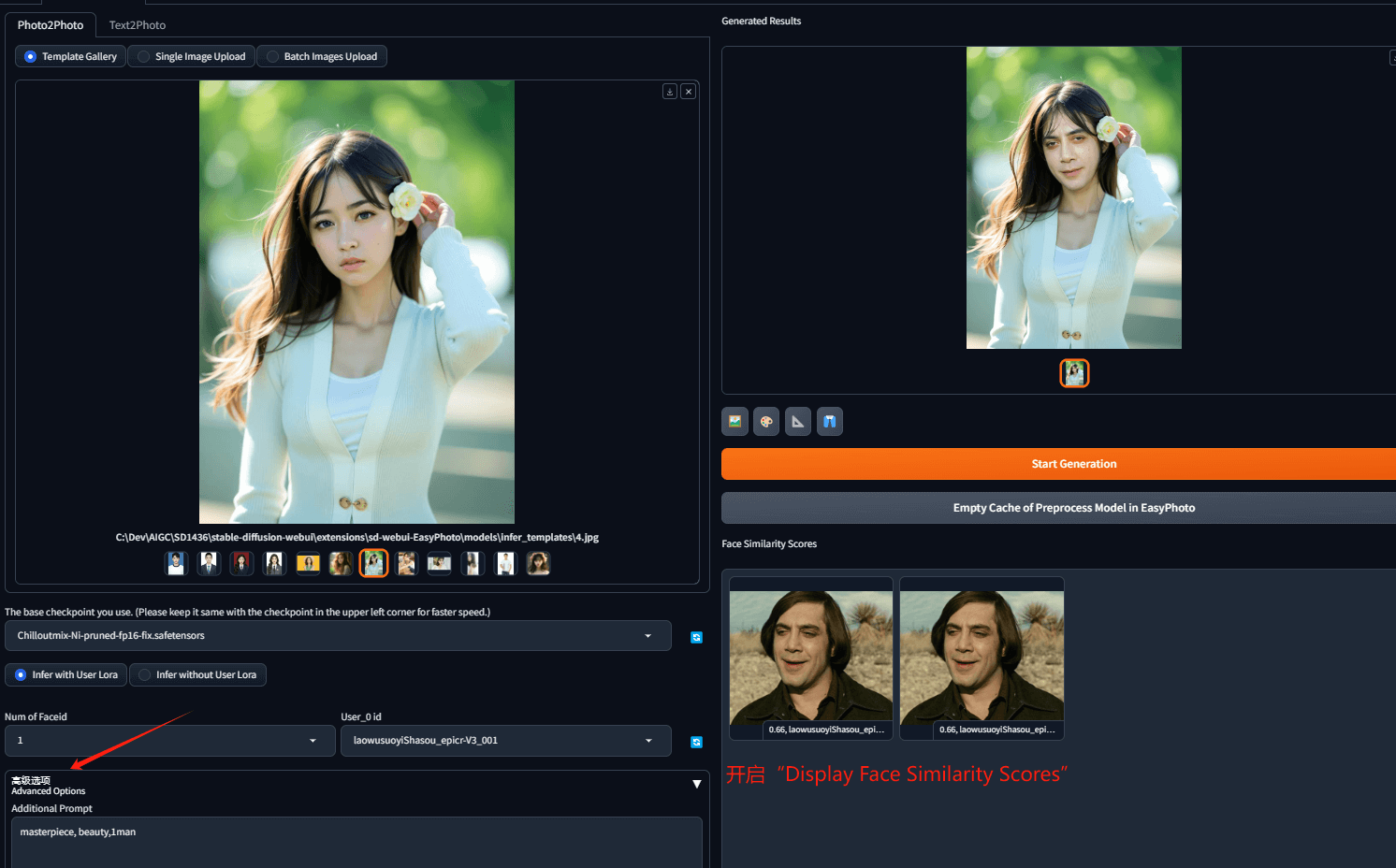

废话不错说,下面是基本的操作步骤~~其实和之前使用图生图做换脸是一样的:

——over

转载请注明出处: 昆仑的山头

时间线

- 2025 年 7 月 (2)

- 2025 年 4 月 (1)

- 2025 年 2 月 (2)

- 2024 年 12 月 (1)

- 2024 年 11 月 (1)

- 2024 年 7 月 (1)

- 2024 年 6 月 (1)

- 2024 年 5 月 (2)

- 2024 年 4 月 (3)

- 2024 年 3 月 (9)

- 2023 年 12 月 (1)

- 2023 年 11 月 (1)

- 2023 年 10 月 (1)

- 2023 年 5 月 (1)

- 2023 年 4 月 (1)

- 2022 年 12 月 (5)

- 2022 年 10 月 (1)

- 2022 年 7 月 (1)

- 2022 年 6 月 (1)

- 2022 年 3 月 (1)

- 2022 年 1 月 (3)

- 2021 年 12 月 (2)

- 2021 年 11 月 (1)

- 2021 年 10 月 (2)

- 2021 年 9 月 (1)

- 2021 年 8 月 (2)

- 2021 年 7 月 (2)

- 2021 年 6 月 (1)

- 2021 年 4 月 (2)

- 2021 年 3 月 (1)

- 2021 年 2 月 (1)

- 2020 年 12 月 (1)

- 2020 年 5 月 (2)

- 2019 年 6 月 (1)

- 2019 年 5 月 (1)

- 2018 年 8 月 (2)

- 2018 年 4 月 (1)

- 2018 年 3 月 (1)

- 2018 年 2 月 (1)

- 2017 年 11 月 (1)

- 2017 年 5 月 (1)

- 2017 年 3 月 (1)

- 2017 年 1 月 (3)

- 2016 年 9 月 (3)

- 2016 年 6 月 (2)

- 2016 年 5 月 (1)

- 2016 年 1 月 (1)

- 2015 年 10 月 (1)

- 2015 年 9 月 (1)

- 2015 年 8 月 (1)

- 2015 年 7 月 (5)

- 2015 年 4 月 (5)

- 2014 年 5 月 (1)

- 2014 年 4 月 (1)

- 2014 年 3 月 (2)

- 2014 年 2 月 (2)

- 2014 年 1 月 (7)

- 2013 年 11 月 (1)

- 2013 年 9 月 (2)

- 2013 年 7 月 (3)

- 2013 年 6 月 (1)

- 2013 年 5 月 (3)

- 2013 年 4 月 (3)

- 2013 年 2 月 (3)

- 2013 年 1 月 (10)

- 2012 年 12 月 (3)

- 2012 年 11 月 (2)

- 2012 年 10 月 (3)

- 2012 年 9 月 (3)

- 2012 年 8 月 (1)

- 2012 年 7 月 (7)

- 2012 年 6 月 (5)

- 2012 年 5 月 (7)

- 2012 年 4 月 (3)

- 2012 年 3 月 (4)

- 2012 年 2 月 (8)

- 2012 年 1 月 (9)

- 2011 年 12 月 (3)

- 2011 年 11 月 (4)

- 2011 年 10 月 (5)

- 2011 年 9 月 (3)

- 2011 年 8 月 (5)

- 2011 年 5 月 (1)

- 2011 年 4 月 (5)

- 2011 年 3 月 (11)

- 2011 年 2 月 (6)

- 2010 年 12 月 (1)

- 2009 年 9 月 (1)

- 2009 年 8 月 (1)

- 2009 年 7 月 (1)

- 2008 年 12 月 (2)

- 2008 年 11 月 (4)

- 2008 年 10 月 (4)

七嘴八舌

- 123 发表在《[转]在ios模拟器上实现模拟双指触摸》

- admin 发表在《nodejs-express初体验》

- laozh 发表在《nodejs-express初体验》

- xxx 发表在《玩转微信公号开发(七)——账号体系与oauth登录》

- 银基网 发表在《玩转微信公号开发(七)——账号体系与oauth登录》

关于本站

关于本站